Non è difficile immaginare il volume di curricula ricevuti da Amazon a livello globale. Una montagna di documenti che raccolgono percorsi formativi, esperienze lavorative e competenze di chi cerca un lavoro alla corte di Jeff Bezos. Per analizzarli, al fine di trovare i candidati migliori per occupare le posizioni aperte, il gruppo di Seattle si è messo al lavoro nel 2014 su un sistema di machine learning progettato appositamente a tale scopo.

L’algoritmo sessista

Tutto nella norma, l’ennesima applicazione virtuosa dell’intelligenza artificiale, almeno nelle intenzioni. Invece no, perché gli algoritmi istruiti da Amazon sembrano non potersi scrollare di dosso un atteggiamento sessista che, a parità di preparazione e skill, tende a favorire il curriculum di un uomo rispetto a quello di una donna. A parlarne un report condiviso oggi sulle pagine di Reuters e che fa riferimento alla testimonianza di cinque fonti rimaste anonime, ma ritenute a conoscenza dei fatti.

Dai test condotti internamente è emerso che l’IA tende a penalizzare i CV che includono termini come “women’s” e quelli inoltrati da candidate che hanno frequentato due college statunitensi esclusivamente femminili (i nomi degli istituti non sono stati resi noti). Maggiore peso viene invece conferito a un linguaggio utilizzato prevalentemente dagli uomini, così come a parole come “executed” o “captured”.

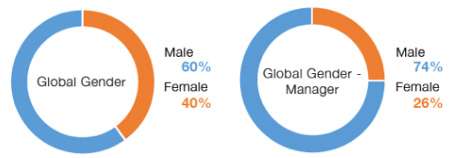

A cosa è dovuto un simile comportamento discriminatorio? A una volontà specifica di Amazon o ad altro? Semplicemente, gli algoritmi sono stati istruiti dando loro in pasto un dataset contenente i curricula dei candidati raccolti dal gruppo nella sua storia e i criteri impiegati nelle assunzioni, ma considerando come la maggior parte dei dipendenti oggi impiegati a livello globale sia di sesso maschile (60% uomini, 40% donne), l’IA si comporta replicando la stessa dinamica.

A poco sono serviti i tentativi di correggere in corsa la condotta del sistema. I modelli di analisi hanno finito per restituire in output una selezione di CV meno coerente con le esigenze della società, tanto che il suo utilizzo è stato interrotto lo scorso anno. L’idea non è comunque stata del tutto abbandonata: secondo Reuters, un team allestito dalla società nella propria sede di Edimburgo è già al lavoro per la realizzazione di un nuovo algoritmo.

Da Amazon, che da tempo mette in evidenza il proprio impegno finalizzato a favorire diversità e inclusione nella propria forza lavoro, non sono giunti commenti né dichiarazioni in merito al report. L’anomalia comportamentale dell’IA può inoltre costituire un valido spunto di riflessione per comprendere come le stesse potenzialità del machine learning, che permettono di istruire un’intelligenza sulla base di un insieme preconfezionato di informazioni, rendano il sistema stesso impermeabile o comunque meno elastico a successivi interventi correttivi.