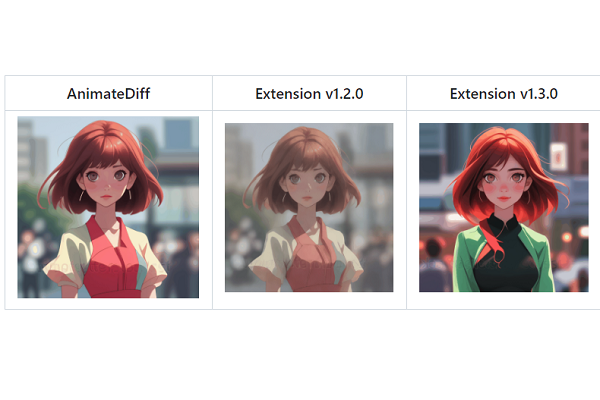

Stable Diffusion è una tecnica di intelligenza artificiale che permette di generare immagini realistiche e creative a partire da un semplice schizzo. Oltre le immagini grazie a AnimateDiff, un’estensione di Stable Diffusion, è possibile creare anche dei video animati con l’intelligenza artificiale. Infatti, AnimateDiff è uno strumento divertente e innovativo che permette di sperimentare con i video per esplorare nuove forme di espressione visiva. Inoltre è un modo per scoprire le potenzialità dell’intelligenza artificiale per creare video sorprendenti e originali, che possono essere usati per vari scopi, come l’intrattenimento, la pubblicità, l’educazione o l’arte.

Come installare AnimateDiff

AnimateDiff è un’estensione per Stable Diffusion che permette di creare animazioni a partire dalle immagini generate. AnimateDiff può essere aggiunta attraverso la scheda “Estensioni” nell’interfaccia utente di Stable Diffusion, denominata AUTOMATIC1111. Una volta installata l’estensione, si potrà proseguire tra i nuovi modelli di movimento e il campo di testo per inserire il prompt della animazione.

Per procedere con l’installazione dell’estensione, è necessario clonare il progetto dal repository GitHub e successivamente trasferirlo nella cartella delle estensioni corrispondente. Il processo garantisce che l’estensione sia correttamente integrata nel vostro sistema. Ecco come installare l’estensione AnimateDiff:

- Avviare l’interfaccia utente Web di AUTOMATIC1111;

- Selezionare la pagina delle estensioni;

- Cliccare sulla scheda “Installa da URL”.

- Inserire l’URL AnimateDiff del repository git dell’estensione nel campo “URL per il repository git dell’estensione”;

- Attendere il messaggio di conferma che indica che l’installazione è stata completata con successo;

- Riavviare AUTOMATIC1111.

Scaricare il modulo di movimento

AnimateDiff è uno strumento che permette di aggiungere movimento alle immagini generate con Stable Diffusion. Tuttavia, prima di poter sfruttare appieno le capacità di AnimateDiff, è indispensabile scaricare almeno un modulo di movimento. Questo passaggio preliminare è fondamentale per garantire il corretto funzionamento di AnimateDiff.

Nel caso in cui si procede scaricando un solo modulo è possibile scegliere mm_sd_v15_v2.ckpt. Oppure le due versioni precedenti disponibili, che sono mm_sd_v15.ckpt e mm_sd_v14.ckpt. Nello specifico per scaricare il modulo di movimento è necessario procedere in questo modo:

- Scaricare il modulo di movimento;

- Inserire nella cartella stable-diffusion-webui > extensions > sd-webui-animatediff > model. Dopo aver scaricato i file ckpt del modulo di movimento;

- Selezionare un modello a diffusione stabile, ad esempio un personaggio realistico chiamato CyberRealistic v3.3;

- Scaricare il modello;

- Inserire in stable-diffusion-webui > models > Stable-Diffusion;

- Nel menu a discesa selezionare cyberrealistic_v33.safetensors.

Impostare le preferenze in AnimateDiff

A questo punto è necessario impostare le preferenze in AnimateDiff. Una volta installata l’estensione AnimateDiff, sarà disponibile nella parte inferiore dell’interfaccia Stable Diffusion. Per procedere, fare clic sull’opzione “AnimatedDiff” e l’interfaccia dovrebbe aprirsi. Tra le impostazioni da configurare si trovano:

- Modulo di movimento: mm_sd_v14.ckpt;

- Numero di fotogrammi: almeno 8 fotogrammi per una buona qualità.;

- Fotogrammi al secondo (FPS): velocità di riproduzione, almeno 8-12.

Opzioni avanzate su AnimateDiff

AnimateDiff offre una serie di opzioni avanzate per migliorare la qualità e la fluidità dei video generati. Tra queste l’opzione a ciclo chiuso, nello specifico assicura che il video sia continuo, facendo in modo che il primo fotogramma sia identico all’ultimo. Questo processo elimina qualsiasi salto improvviso durante la transizione dall’ultimo al primo fotogramma, rendendo il video più fluido e naturale.

Un altro metodo per rendere il video continuo è l’aggiunta di fotogrammi invertiti. Questa opzione raddoppia la lunghezza del video, aggiungendo il video originale riprodotto all’indietro. L’opzione crea l’illusione di un movimento continuo, migliorando ulteriormente la fluidità del video. Ma anche la dimensione batch del contesto che controlla la coerenza temporale del video. Una dimensione batch di contesto più elevata riduce le modifiche al video, garantendo una maggiore coerenza nel tempo.

Infine, impostare l’opzione “Frame Interpolation” su “FILM” e “Interp X” su un moltiplicatore di FPS, per aumentare la fluidità del video aumentando il numero di fotogrammi al secondo.

Come creare un video con AnimateDiff

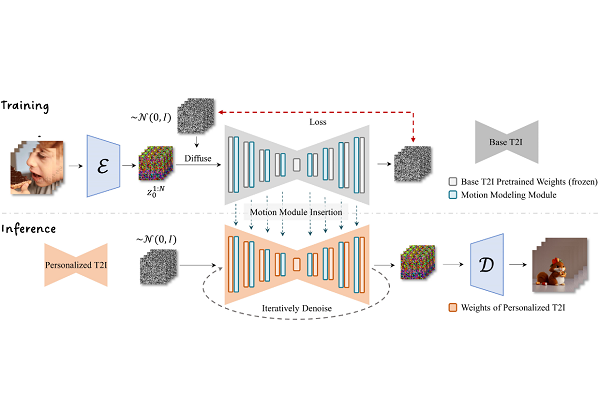

Infine, dopo tutte le scelte per la realizzazione dei video, è necessario premere “Genera” per creare un video. Basterà attendete qualche secondo, per vedere realizzato il video animato, è possibile salvare l’elaborato sul computer o condividere sui social network. AnimateDiff è quindi un potente strumento, ma per ottenere i migliori risultati è necessario sperimentare e provare. Nello specifico, il modulo di controllo è addestrato con una varietà di brevi video clip, e durante il processo di generazione delle immagini, condiziona il modello per produrre una serie di immagini che assomigliano ai video clip appresi. Questo processo permette al modulo di apprendere i movimenti e le transizioni presenti nei video.

Durante la generazione delle immagini, il modulo di controllo condiziona il processo per produrre una serie di immagini che assomigliano ai video clip appresi. In altre parole, il modulo guida il modello di diffusione stabile per creare una sequenza di immagini che sembrano muoversi in modo simile ai video clip originali. Una delle caratteristiche più potenti di AnimateDiff è che il suo modulo di controllo può essere utilizzato con qualsiasi modello di diffusione stabile. Attualmente, sono supportati solo i modelli Stable Diffusion v1.5.

I limiti di AnimateDiff

Tuttavia, ci sono alcune limitazioni da tenere a mente, AnimateDiff produce un movimento generico basato su ciò che ha appreso dai dati di addestramento. Non produrrà un video che segue una sequenza dettagliata di movimenti specificati nel prompt. La qualità del movimento è sensibile ai dati di allenamento. Se si tenta di animare un’immagine con uno stile o un soggetto che non è presente nei dati di addestramento, i risultati potrebbero non essere ottimali.