Difesa della privacy o lotta alla pedopornografia? Apple ritiene possa esserci una via di mezzo percorribile, un lecito compromesso che possa mantenere al sicuro la sfera privata pur entrandoci a occhi bendati per fermare la diffusione di immagini problematiche. Cupertino ha infatti annunciato una nuova tecnologia con la quale andrà ad analizzare le immagini destinate ai server iCloud, alla ricerca di “match” con un database del National Center for Missing & Exploited Children (NCMEC): in caso di corrispondenze legate all’impronta digitale dell’immagine, l’account potrebbe essere bloccato.

Le immagini sarebbero analizzate direttamente sullo smartphone dell’utente, inviate quindi ad iCloud accompagnate dall’esito della verifica della corrispondenza. Secondo Apple i falsi positivi sarebbero un quantitativo del tutto trascurabile e consentirebbero di agire esclusivamente sui casi estremamente gravi di una corrispondenza.

Il processo è stato illustrato compiutamente da Apple in questo documento. Su questa pagina Apple ha invece spiegato quali siano i propri piani per un ulteriore impegno in termini di Child Sexual Abuse Material (CSAM).

NeuralHash

La tecnologia NeuralHash è difesa da Apple come approccio virtuoso al problema: un modo per difendere la privacy degli utenti e, al tempo stesso, portare avanti la lotta alla pedopornografia come e più di altri gruppi attivi sul cloud in modo similare. Le preoccupazioni vengono però da gruppi come la Electronic Frontier Foundation, secondo cui uno strumento similare potrebbe diventare estremamente pericoloso se utilizzato, forzato e strumentalizzato da possibili ritorsioni di Paesi liberticidi.

Se nel merito l’idea è evidentemente virtuosa, quel che spaventa i detrattori sta nei possibili abusi di una tecnologia particolarmente invasiva, pur se con tutte le precauzioni del caso. La EFF in particolare fa notare come ciò che nasce contro la pedopornografia potrebbe potenzialmente diventare un ostacolo anche ad altri tipi di immagini, esondando su altre tematiche e diventando un occhio indiscreto sul privato.

This sort of tool can be a boon for finding child pornography in people’s phones. But imagine what it could do in the hands of an authoritarian government? https://t.co/nB8S6hmLE3

— Matthew Green (@matthew_d_green) August 5, 2021

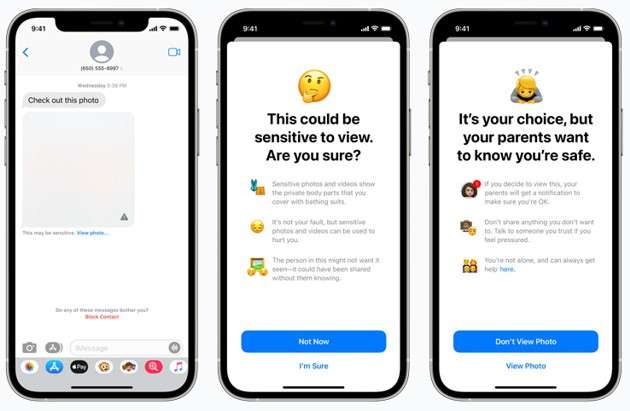

Le ambizioni Apple sarebbero inoltre ampliate anche a Messaggi, dove potrebbero essere tutelati i minori da invii e ricezioni pericolose. Nel caso in cui le immagini veicolate dovessero essere catalogate come “esplicite”, il minore potrà comunque aprirle, ma sapendo che una notifica sarà inviata ai genitori – i quali potranno personalmente controllare la situazione e valutare il da farsi.

Le novità entreranno in vigore, per il momento solo negli USA, con i nuovi iOS 15, iPadOS 15, watchOS 8 e macOS Monterey. La sensazione è che potranno essere vagliati dalle autorità (soprattutto europee) prima di entrare in vigore, ma il passo in avanti in termini di sicurezza sono innegabilmente virtuosi.

Resta la necessità di validare l’intero processo al di là degli algoritmi di verifica e crittazione: l’integrità del database NCMEC, la capacità di blindare le regole all’invadenza degli Stati nazionali e altri aspetti sono cruciali quanto e più della bontà della soluzione tecnica implementata.

Uno screening internazionale sul sistema è pertanto un passaggio doveroso, dal quale si auspica possano scaturirne best practice sempre più restrittive nei confronti di abusi e malintenzionati. Privacy permettendo, perché su questo fronte sono altri i diritti inalienabili in ballo.