Amazon Web Services ha annunciato due nuovi chip durante la conferenza AWS re:Invent 202 di Las Vegas. AWS Trainium2 verrà utilizzato nelle istanze EC2 UltraClusters per l’addestramento dei modelli di intelligenza artificiale generativa. AWS Graviton4 troverà posto nelle istanze EC2 R8g e servirà per l’esecuzione dei modelli (inferenza), oltre che per altre applicazioni cloud.

AWS Trainium2: training dei modelli IA

Quasi tutte le aziende che sviluppano modelli di intelligenza artificiale generativa usano le GPU di NVIDIA per l’addestramento. Amazon ha progettato chip custom per ridurre la dipendenza da NVIDIA. A distanza di circa tre anni dal lancio della prima generazione è stato annunciato AWS Trainium2.

Il chip consente il training dei LLM (Large Language Model) con trilioni di parametri, offrendo prestazioni fino a quattro volte superiori a Trainium, una capacità di memoria fino a tre volte superiore e un’efficienza energetica (performance/watt) fino a due volte superiore.

Trainium2 sarà disponibile nelle istanze EC2 Trn2 con 16 chip. In futuro verrà usato nelle istanze EC2 UltraClusters con un massimo di 100.000 chip che raggiungono i 65 exaflops. L’addestramento dei modelli di grandi dimensioni verrà completato in settimane, invece che in mesi, ottenendo una diminuzione dei costi. Uno dei clienti di AWS è Anthropic.

AWS Graviton4: inferenza dei modelli IA

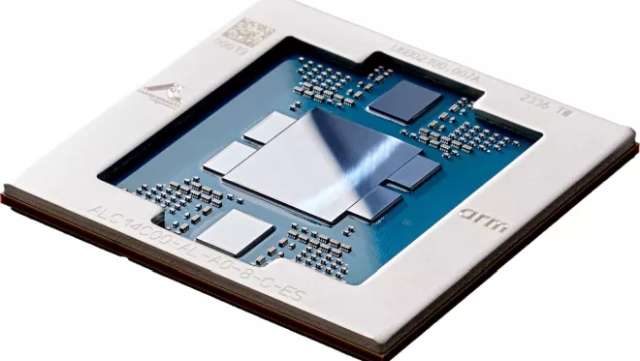

AWS Graviton4 è invece un chip basato su architettura ARM. La quarta generazione integra 96 core Neoverse, 2 MB di cache L2 per core e 12 canali di memorie DDR5-5600. Come detto verrà usato per l’inferenza dei modelli di IA generativa, ma anche per applicazioni general purpose, come database, web app e app Java. Sarà disponibile nelle istanze EC2 R8g.

Amazon continuerà ovviamente ad usare le GPU NVIDIA. Durante il re:Invent 2023 ha annunciato tre nuove istanze EC2. Le EC2 P5e integreranno le GPU NVIDIA H200, le più potenti sul mercato che permettono l’addestramento e l’inferenza dei LLM (Large Language Model).

Per il training degli SLM (Small Large Language) sarà possibile sfruttare le istanze EC2 G6e con GPU NVIDIA L40S. Le GPU NVIDIA L4 verranno usate nelle istanze EC2 G6 per eseguire varie attività: riconoscimento del linguaggio naturale, traduzione, analisi di immagini e video, riconoscimento vocale e game streaming.