Durante la conferenza Ignite 2023, Microsoft ha annunciato molte novità relative all’intelligenza artificiale generativa. L’azienda di Redmond ha svelato inoltre il primo acceleratore custom per l’addestramento dei modelli IA (Azure Maia 100) e una CPU per le gestione dei carichi di lavoro cloud (Azure Cobalt 100).

Microsoft Azure Maia 100 e Cobalt 100

Microsoft, come quasi tutte le aziende che sviluppano modelli di IA generativa, utilizza principalmente le GPU di NVIDIA nei server dell’infrastruttura Azure. L’incremento della domanda di soluzioni basate sui LLM (Large Language Model) e quelle text-to-image comporta un continuo aggiornamento hardware. Microsoft ha deciso di ridurre la dipendenza da NVIDIA con la progettazione di Azure Maia 100.

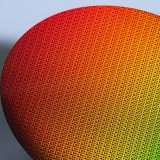

Il chip, realizzato con tecnologia di processo a 5 nanometri, integra 105 miliardi di transistor e verrà sfruttato per l’addestramento e l’inferenza dei modelli IA usati in Microsoft Copilot (ex Bing Chat) e Bing Image Creator, basati su GPT-4, GPT-3.5 Turbo e DALL-E 3.

Microsoft non ha fornito ulteriori dettagli tecnici, ma ha solo specificato che Maia 100 è il primo processore per server con raffreddamento a liquido progettato dall’azienda. All’interno di ogni rack è presente un refrigeratore che funziona in modo simile al radiatore di un’automobile. Microsoft continuerà ad usare le GPU NVIDIA H100 e le nuove H200.

Azure Cobalt 100 è invece una CPU con 128 core basata sull’architettura ARM Neoverse. Offre prestazioni fino al 40% superiori a quelle delle CPU attualmente utilizzate nei server Azure. Verrà sfruttata principalmente per i servizi Microsoft Teams e Azure SQL, ma in futuro sarà disponibile anche nelle macchine virtuali.

Microsoft ha inoltre annunciato Azure Boost, un sistema che consente di incrementare le prestazioni di storage e rete per le macchine virtuali.