Nel corso degli ultimi anni il machine learning ha ampliato il proprio raggio d’azione passando dai laboratori di ricerca a un contesto molto più ampio che oggigiorno riguarda tutti noi e i servizi ai quali ci affidiamo quotidianamente. Una dinamica che ha portato con sé l’esigenza di garantire che gli algoritmi impiegati siano istruiti in modo da non mostrare il fianco a comportamenti di tipo discriminatorio o potenzialmente lesivo per la privacy. Lo sa bene Microsoft che oggi in occasione dell’evento Build 2020 rivolto alla community di sviluppatori annuncia una serie di innovazioni su questo fronte.

Build 2020: machine learning e responsabilità

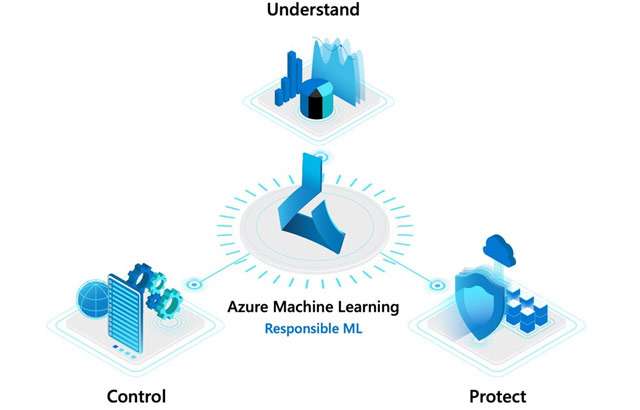

Nella sua presentazione il gruppo di Redmond fa più volte riferimento al termine “responsabilità”. L’obiettivo è anzitutto quello di aiutare chi scrive codice a capire il cosiddetto model behavior. Tra gli strumenti offerti a tale scopo citiamo WhiteNoise, un toolkit reso disponibile con formula open source su GitHub e accessibile attraverso Azure Machine Learning, messo a punto in collaborazione con i ricercatori del Harvard Institute for Quantitative Social Science and School of Engineering.

Consente di ottenere insight da dati privati garantendone al tempo stesso il massimo livello di tutela, un approccio utile ad esempio per condurre le sperimentazioni in ambito clinico dove un’innovazione legata all’analisi delle informazioni può avere benefici per la collettività, ma vi è anche l’esigenza di garantire la protezione per nomi, cognomi, cartelle cliniche e altri dati sensibili.

La novità si inserisce a pieno titolo nel percorso intrapreso da Microsoft in relazione alla piattaforma Azure con le potenzialità del cloud e quelle degli strumenti IA sempre più interconnesse e complementari.