C’è una nuova parola da imparare nel laboratorio del Metaverso di Mark Zuckerberg: CAIRaoke. Semplificando, CAIRaoke può essere immaginata come la piattaforma da cui nasceranno i discendenti di Alexa, dando vita ad un tipo di interazione uomo-macchina non più basato soltanto su una serie di combinazioni preordinate, ma su una reale comprensione reciproca, dinamica e imparativa.

“Più conversazionale e più efficiente“: così Alborz Geramifard, AI Research Manager di Meta, enuncia il tipo di interazione che intende costruire. Il tutto consta di un modello neurale end-to-end “per consentire interazioni multimodali immersive con gli assistenti del futuro“.

Meta ha sottolineato le debolezze dei modelli attuali ed ha enunciato i propri obiettivi futuri – qualcosa che andrebbe a rendere del tutto superate le abitudini attuali di interazione con assistenti basati su formule obbligate e risposte preordinate.

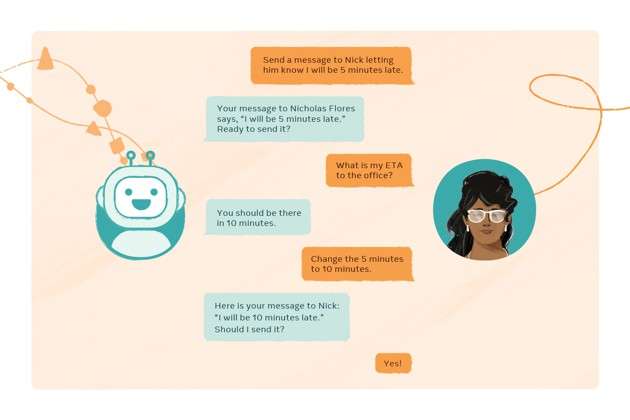

Usando i modelli creati con Project CAIRaoke, le persone potranno parlare in modo naturale ai propri assistenti conversazionali, e quindi fare riferimento a qualcosa di già detto prima nella conversazione, cambiare del tutto tema o nominare cose che dipendono dalla comprensione di un contesto complesso e sfumato. Saranno anche in grado di interagire con loro usando nuove modalità, ad esempio i gesti.

CAIRaoke: un nuovo modello di assistente vocale

La grande differenza starà nella comprensione del contesto. Un esempio fornito da Meta:

- Imposta un promemoria per le 6:30.

- Di mattina o di sera?

- Di sera. Chiamalo comprare uova.

- Ok, il tuo promemoria di comprare uova è impostato per domani alle 6:30 di sera.

Con Alexa l’impostazione di un nome del timer non è automatico, ad esempio, ma previsto come opzione standard soltanto dal secondo timer sovrapposto in poi e soltanto sulla base di uno scambio preordinato dove è l’assistente a porre domande e l’utente a rispondere. La nuova prospettiva cambierebbe completamente i ruoli, consegnando agli utenti il timone della discussione affinché possano portarla dove desiderano sulla base dei limiti comprensivi dell’IA.

Crediamo che i progressi compiuti con Project CAIRaoke ci consentiranno di offrire comunicazioni più ricche tra le persone e l’IA, che saranno uno strumento essenziale via via che proseguiremo nella costruzione del metaverso. Un giorno un assistente basato su CAIRaoke incorporato in occhiali AR potrebbe seguirci in una quantità di nuovi e utili modi. Per esempio, chiedendogli “Cosa sta bene con questi pantaloni?” potrebbe rispondere “Ecco una camicia del tuo colore preferito, il rosso” e mostrare l’immagine di un articolo che ha trovato per noi. E se rispondessimo “Mi piace, ma ha le righe troppo larghe”, ci mostrerebbe in cambio una versione a righe più strette.

Meta ritiene che per arrivare a questo tipo di obiettivo occorra sviluppare un nuovo modello integrato, evitando di distinguere l’approccio alla comprensione con quello all’interazione. CAIRaoke vuole essere esattamente la struttura di questo nuovo modo di procedere, alienando i flussi conversazionali imposti per ottenere un risultato più ambizioso:

Con il nostro nuovo approccio i sistemi di dialogo diventano molto più robusti, perché sono in grado di prendere decisioni cercando su tutta la gamma di informazioni disponibili, in un unico luogo. In precedenza, perfino un piccolo errore in un componente poteva propagarsi agli altri, in modi inattesi e difficili da risolvere. Per fare un esempio, gli attuali assistenti basati su regole sono esplicitamente programmati per cercare parole o frasi specifiche, come “p.m.” dopo un numero a significare che si tratta di un orario pomeridiano. Invece Project CAIRaoke utilizza evoluti modelli linguistici preaddestrati che comprendono meglio il contesto e possono riconoscere diversi modi per dire la stessa cosa.

Si parte da Portal: su questo device potrà essere applicato CAIRaoke in attesa di un’espansione ad altri device e altre lingue. Meta spera di poter portare entro pochi anni questa tecnologia su un alto numero di device, cercando di portare l’assistente vocale nella vita di ognuno attraverso occhiali, visori VR, smartphone e qualunque altro dispositivo possa renderne ubiqua la presenza nella quotidianità.

Secondo Meta, infatti, l’impatto di questo nuovo tipo di tecnologia sarà estremamente più ampio rispetto agli assistenti attuali, risolvendo molti più problemi e rendendone molto più rapida l’evoluzione:

In un futuro non troppo lontano, le persone useranno regolarmente gli assistenti vocali nei loro occhiali AR, come adesso fanno con altoparlanti, orologi e altri dispositivi smart. Alla luce di ciò, stiamo lavorando per ridurre le dimensioni dei modelli end-to-end di questo tipo in modo da poterli integrare sul dispositivo, perché i modelli on-device offrono anche vantaggi aggiuntivi in termini di sicurezza, privacy e prestazioni. L’altro lavoro che stiamo facendo è rendere il modello più efficiente in termini di debug: una sfida complessa, questa, perché con questo nuovo framework l’informazione è rappresentata nello spazio di incorporamento, mentre nel modello canonico è esplicita.

La presenza di un assistente nella quotidianità sarà l’incarnazione di quel ponte tra realtà e Metaverso che Meta ha l’ambizione di costruire. Proprio il controllo di questi hub, infatti, potrà essere l’elemento prezioso del modello di business che Zuckerberg intravede per la propria società.