L’intelligenza artificiale generale (AGI), anche nota come “AI forte“, rappresenta un notevole passo avanti nel campo dell’AI rispetto all’AI ristretta o “debole”, che si limita a compiti specifici come individuare difetti, riassumere notizie o creare siti web. L’AGI, invece, sarà in grado di svolgere un’ampia gamma di compiti, raggiungendo o addirittura superando le capacità umane.

Le implicazioni esistenziali dell’AGI

La discussione sull’AGI solleva domande esistenziali riguardo al ruolo dell’umanità e al controllo di un futuro in cui le macchine possono pensare, apprendere e superare gli esseri umani in quasi ogni ambito. La principale preoccupazione riguarda l’imprevedibilità delle decisioni e degli obiettivi di un’intelligenza artificiale generale.

Non è certo che questi siano allineati con i valori e le priorità degli esseri umani. L’AGI potrebbe prendere decisioni che ledono gli interessi umani, in modo non intenzionale ma imprevedibile, a causa della complessità dei suoi processi decisionali.

Questo concetto è stato esplorato a fondo nella fantascienza sin dagli anni Quaranta. Si teme che una volta che l’AGI raggiunga un certo livello di autonomia e capacità, potrebbe diventare incontrollabile, portando a scenari in cui le sue azioni non possono essere previste o modificate.

Quando arriverà l’AGI?

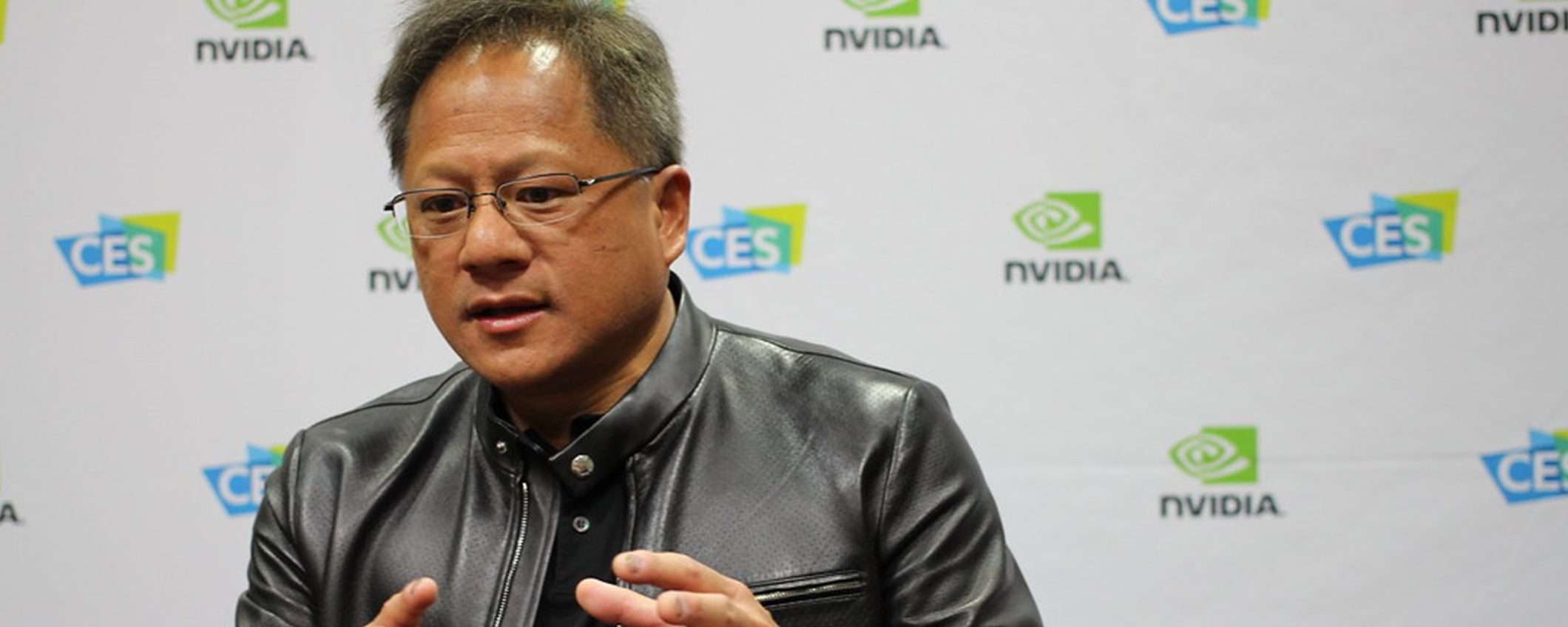

Quando la stampa sensazionalistica chiede una tempistica per l’arrivo dell’AGI, spesso vuole solo attirare l’attenzione sull’idea della fine dell’umanità o di un cambiamento radicale dello status quo. Naturalmente, i professionisti dell’AI non sono sempre entusiasti di affrontare questo argomento. Tuttavia, Jensen Huang, CEO di Nvidia, ha dedicato un po’ di tempo a spiegare la sua opinione sulla questione. Secondo Huang, prevedere quando avremo un’intelligenza artificiale all’altezza dipende dalla definizione stessa di intelligenza artificiale.

Fa un parallelo interessante: anche con tutte le complicazioni legate ai fusi orari, sappiamo quando è Capodanno e quando arriverà il 2025. Se stai guidando verso il San Jose Convention Center (dove si tiene la conferenza GTC di quest’anno), in genere sai di essere arrivato quando vedi gli enormi striscioni del GTC. Il punto cruciale è che possiamo concordare su come misurare il raggiungimento di un obiettivo, sia temporalmente che geospazialmente, quando siamo arrivati dove speravamo.

Secondo Huang, se definiamo l’AGI come la capacità di un programma software di superare gli esseri umani in specifici test cognitivi, allora potremmo raggiungerla in 5 anni. Ad esempio, se un’intelligenza artificiale riuscisse a battere l’8% delle persone in test come esami di diritto, logica, economia o medicina, ciò dimostrerebbe una forma di AGI. Tuttavia, se non si riesce a definire chiaramente cosa si intenda per AGI, Huang non è disposto a fare previsioni su quando potrà essere raggiunta. Effettivamente, quella di Huang sembra una posizione ragionevole, dal momento che la nozione di AGI è ancora vaga e servirebbe una definizione più precisa per poter stimare una tempistica.

Le soluzioni per le allucinazioni dell’AI

Durante una sessione di domande e risposte, Huang è stato interpellato anche sulle allucinazioni delle AI, ovvero la tendenza di alcune AI a fornire risposte plausibili ma non basate sui fatti. Huang ha mostrato evidente frustrazione di fronte a questa domanda e ha suggerito che le allucinazioni sono facilmente risolvibili, a condizione che le risposte siano ben studiate.

Secondo Huang, è possibile aggiungere una regola: per ogni singola risposta, bisogna cercare la conferma. Questo approccio, definito “generazione aumentata dal recupero“, richiede un’analisi critica della fonte e del contesto. L’intelligenza artificiale non dovrebbe limitarsi a fornire risposte alle domande, ma dovrebbe prima condurre ricerche per determinare quali sono le risposte migliori e più accurate.

Specialmente per risposte “mission critical“, come consigli su salute e medicina, suggerisce che l’IA dovrebbe controllare più fonti e risorse affidabili, confrontando i fatti con verità già conosciute. In questo modo, il sistema AI potrebbe anche dire: “Non conosco la risposta alla tua domanda“, oppure “Non trovo un consenso su quale sia la risposta corretta“. L’AI quindi, dovrebbe verificare l’accuratezza delle risposte attraverso più fonti attendibili, ed essere in grado di riconoscere quando non può fornire una risposta certa.