ChatGPT può essere utilizzato per eseguire diversi compiti, tra cui la scrittura del codice dei malware e poesie (ma non su Donald Trump). L’intelligenza artificiale sviluppata da OpenAI non fornisce invece risultati esatti a semplici calcoli matematici. Gli studenti dovrebbe quindi evitare ChatGPT se non vogliono ricevere un voto negativo.

ChatGPT bocciato in matematica

Paul von Hippel, professore dell’università del Texas (Austin) ha testato le conoscenze di ChatGPT sul teorema di Pitagora. Le risposte ottenute dal chatbot sono quasi sempre corrette, ma in un caso ha sbagliato i calcoli, scrivendo che il risultato 3,852 è 15,0225, invece di 14,8225.

Un giornalista del Wall Street Journal ha voluto testare più a fondo le competenze di ChatGPT, scoprendo che spesso le risposte sono grammaticamente corrette, ma matematicamente sbagliate. Alla domanda (in inglese)

Se una banana pesa 0,5 libbre e io ho 7 libbre di banane e nove arance, quanti pezzi di frutta ho?

ChatGPT ha risposto

Hai 16 pezzi di frutta, sette banane e nove arance.

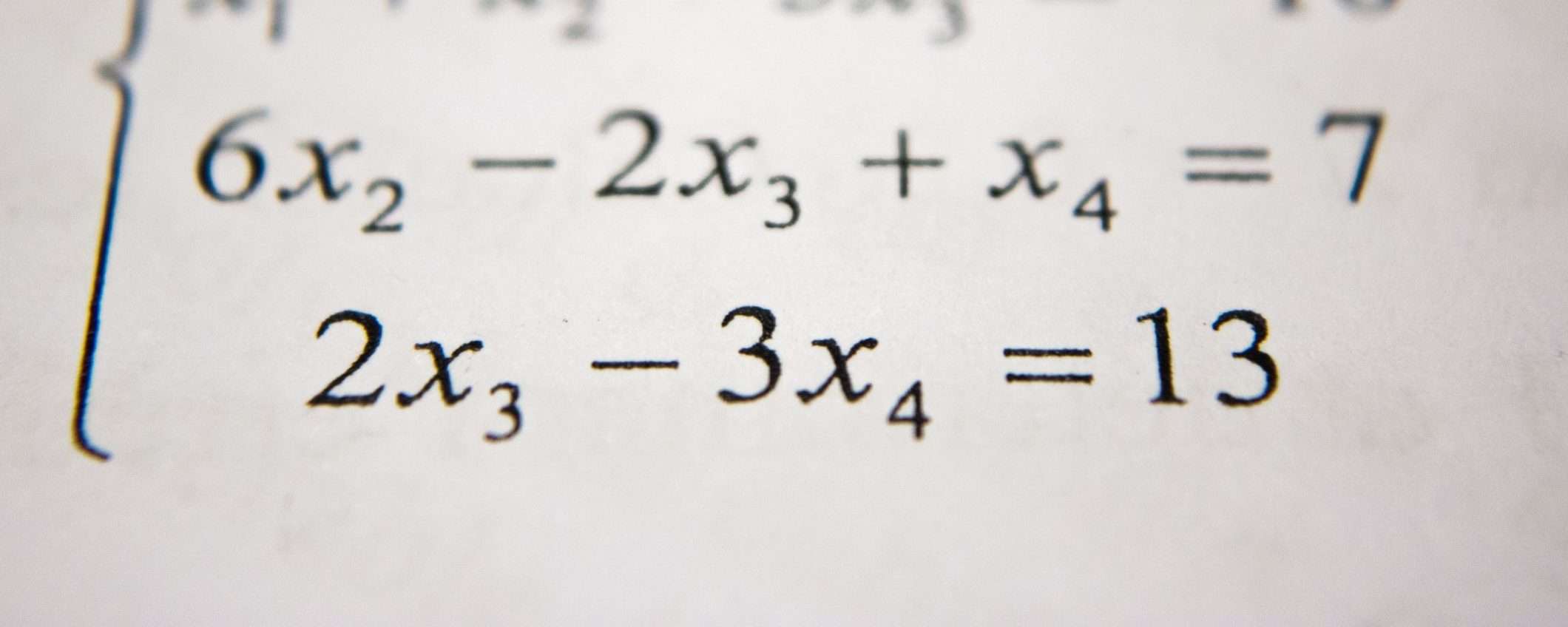

Chiaramente la risposta è sbagliata, in quanto le banane sono 14, quindi i pezzi di frutta sono 23. L’intelligenza artificiale non è nemmeno in grado di risolvere una semplice equazione, come questa:

3x + 4 = 11

La risposta è stata 3, invece di 7/3. Gli studenti dovrebbe evitare ChatGPT e risolvere i problemi matematici senza aiuto esterno (alcune scuole statunitensi hanno bloccato l’accesso al chatbot) o al massimo usare tool più avanzati, come Wolfram Alpha.

Un giudice colombiano ha invece testato le competenze legali di ChatGPT. Dopo aver chiesto al chatbot alcune informazioni ha utilizzato le risposte per velocizzare la scrittura della sentenza.