ChatGPT è diventato una parte importante del nostro flusso di lavoro, spesso sostituendo persino Google Search per molte ricerche. Molti di noi utilizzano il chatbot di OpenAI per query semplici, ma grazie ai plugin e alle estensioni dedicate, può essere impiegato anche per compiti più complessi. Tuttavia, consigliamo di prestare attenzione all’uso che si fa di ChatGPT e ai dati che si condividono. Da quanto è emerso, infatti, il chatbot avrebbe fatto trapelare alcune conversazioni private degli utenti.

Allarme privacy per ChatGPT

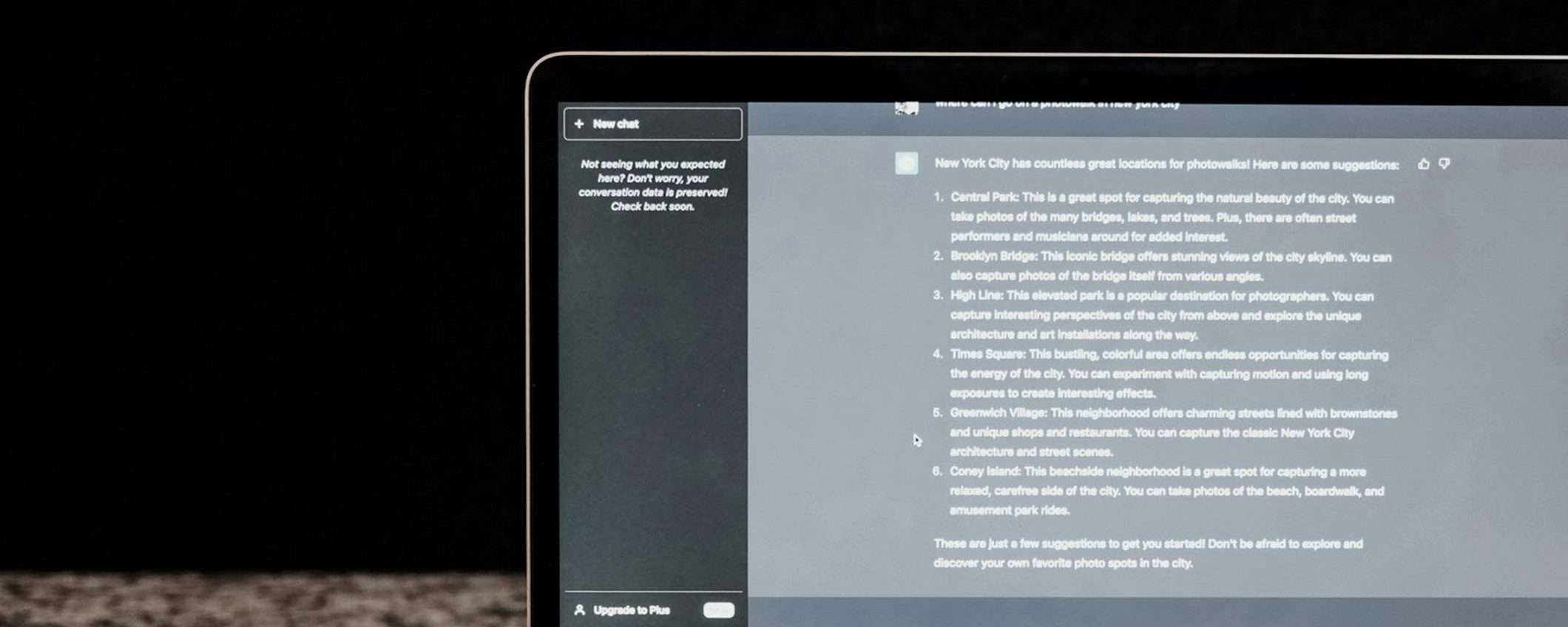

Secondo un rapporto di ArsTechnica, che cita gli screenshot inviati da uno dei suoi utenti, ChatGPT sta facendo trapelare conversazioni private, compresi dettagli come nomi utente e password. Il lettore ha utilizzato il chatbot di OpenAI per una richiesta non correlata e ha notato curiosamente la presenza di conversazioni aggiuntive nella sua cronologia di chat che non gli appartenevano.

Queste conversazioni estranee includevano diversi dettagli sensibili. In una serie di chat, qualcuno stava cercando di risolvere dei problemi tecnici attraverso un sistema di assistenza utilizzato dai dipendenti di un portale di farmaci su prescrizione. Nelle conversazioni erano presenti il nome dell’applicazione per cui si richiedeva supporto, il numero identificativo del negozio in cui si era verificato il problema e ulteriori credenziali di accesso. Questi dati, se resi pubblici, potrebbero permettere l’accesso non autorizzato a informazioni confidenziali e mettere a rischio la privacy degli utenti.

Un’altra conversazione trapelata includeva il nome di una presentazione su cui qualcuno stava lavorando, oltre ai dettagli di una proposta di ricerca non ancora pubblicata. La divulgazione di queste informazioni riservate potrebbe causare danni significativi agli utenti, rivelando idee e progetti delicati prima che siano pronti ad essere condivisi. L’episodio evidenzia ancora una volta le falle nella protezione della privacy di ChatGPT, che dovrà rafforzare le misure di sicurezza per impedire che episodi come questi si ripresentino. La riservatezza delle conversazioni deve essere una priorità assoluta per un’intelligenza artificiale utilizzata da milioni di persone.

Nuova fuga di dati per ChatGPT, è la terza in pochi mesi

Questa non è la prima volta che ChatGPT è coinvolto in una fuga di dati privati. Già a marzo 2023 si era verificato un bug che aveva provocato la divulgazione dei titoli delle conversazioni sulla piattaforma. Inoltre, a novembre dello stesso anno alcuni ricercatori erano riusciti a sfruttare le query per indurre il bot a rivelare numerosi dati riservati utilizzati per l’addestramento dell’intelligenza artificiale.

OpenAI ha dichiarato ad ArsTechnica di aver avviato le indagini. Tuttavia, indipendentemente dai risultati, raccomandiamo estrema cautela nel condividere informazioni private con chatbot AI. I recenti casi dimostrano che le garanzie sulla tutela della riservatezza su queste piattaforme sono ancora insufficienti. Fino a quando non saranno implementate misure adeguate, è consigliabile non affidare a ChatGPT dati sensibili che potrebbero essere impropriamente divulgati.