Tutto come previsto: oggi Meta ha annunciato in via ufficiale Code Llama. Si tratta di un modello linguistico di grandi dimensioni realizzato partendo dalla solida base di Llama 2, introdotto di recente, ottimizzato mediante l’impiego di dataset specifici per operare nell’ambito della programmazione e generare codice. Gratuito per finalità di ricerca e commerciali (la licenza è la stessa di Llama 2), è l’ennesimo strumento IA che tende la mano agli sviluppatori.

Meta: IA e programmazione, ecco Code Llama

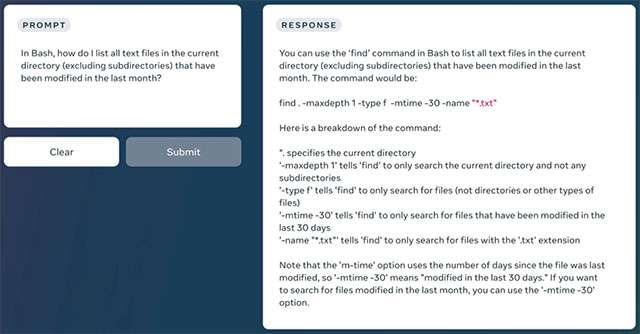

L’interazione si basa sull’invio di un prompt a cui l’intelligenza artificiale replica in modo completo ed esplicativo, come si può osservare nell’esempio qui sotto. L’obiettivo è lo stesso di altri tool e sistemi già visti in azione nello stesso territorio (da GitHub Copilot a OpenAI Codex): rendere più agile il flusso di lavoro e permettere anche ai meno esperti di ottenere i risultati voluti in breve tempo.

Code Llama è in grado di elaborare in input sia richieste come Scrivimi una funzione che restituisca la successione di Fibonacci

sia porzioni di codice da completare o sulle quali eseguire debug.

Il team di Meta al lavoro sul progetto garantisce fin da subito il supporto a tutti i linguaggi di programmazione più popolari e utilizzati: Python, C++, Java, PHP, Typescript (Javascript), C#, Bash e altri.

Code Llama è pensato per affiancare gli ingegnere del software in tutti i settori, inclusi quelli della ricerca, l’industria, i progetti open source, le ONG e i business. Ci sono ancora molti altri casi d’uso da supportare. Speriamo che Code Llama possa ispirare altri a far leva su Llama 2 per realizzare strumenti innovativi, per la ricerca e i prodotti commerciali.

In un primo momento, il modello è rilasciato in tre versioni, rispettivamente da 7 miliardi, 13 miliardi e 34 miliardi di parametri, ciascuno dei quali istruito mediante 500 miliardi di token. Stando a quanto dichiarato, il primo può essere gestito da una singola GPU. Sono disponibili altre due varianti, battezzate Code Llama Python e Code Llama Instruct, per impieghi specifici. Maggiori informazioni nella documentazione dedicata.