Il social network in blu ha condiviso il suo nuovo Rapporto sulla Trasparenza (Community Standards Enforcement Report). Un documento che testimonia l’impegno di Facebook finalizzato a mantenere la piattaforma un luogo sicuro per i suoi utenti. Ironicamente, nelle stesse ore sulle pagine del NYT sono comparse nuove scomode informazioni in merito alla strategia adottata per far fronte alle già tanto discusse interferenze russe (e non solo).

Facebook, il Rapporto sulla Trasparenza

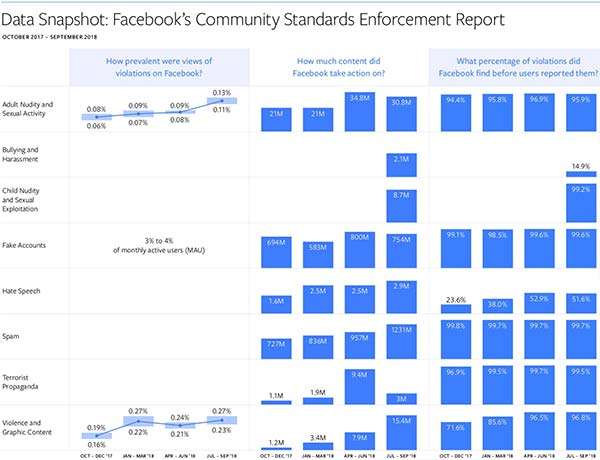

Tornando al rapporto, mostra i frutti del controllo sui contenuti operato attraverso l’impiego della tecnologia e da parte di un team dedicato. I dati fanno riferimento al periodo che va dall’aprile al settembre di quest’anno, includendo informazioni su immagini o video di nudo, attività sessuale, account fake, hate speech, spam, terrorismo e violenza. Per la prima volta FB condivide i numeri della sua lotta a bullismo, molestie e pedopornografia. Ad accompagnare statistiche e grafici il lungo e approfondito intervento di Mark Zuckerberg che apre il post sottolineando il focus della sua attività finalizzata a rendere la piattaforma un luogo più sicuro.

Il mio focus nel 2018 è stato su uno dei più importanti problemi che riguardano Facebook. Con l’anno che giunge al termine, scrivo una serie di note a proposito delle sfide e dei progressi raggiunti.

https://www.facebook.com/notes/mark-zuckerberg/a-blueprint-for-content-governance-and-enforcement/10156443129621634/

Approccio preventivo

Stando a quanto riportato, il gruppo ha compiuto passi in avanti nell’identificare in modo preventivo i contenuti che rappresentano una violazione delle policy, ancor prima che giungano segnalazioni dagli utenti, in particolare per quanto riguarda hate speech e violenza. Rispetto al rapporto precedente, per la prima categoria si è saliti dal 24% al 52% e per la seconda dal 72% al 97%.

I contenuti eliminati

Ancora, nel Q3 2018 sono stati eliminati 15,4 milioni di elementi riconducibili alla violenza (dieci volte di più rispetto al Q4 2017) attraverso misure come la cancellazione dei file, la visualizzazione di un avviso per l’accesso a un contenuto potenzialmente in grado di turbare il pubblico e nei casi più gravi la disattivazione dell’account o la segnalazione alle autorità competenti. Risultati simili per la lotta al terrorismo e alla propaganda estremista, grazie all’impiego di algoritmi in grado di identificare immediatamente i post potenzialmente riconducibili alla pratica.

Gli account fake eliminati sono stati 800 milioni nel Q2 2018 e 754 milioni nel Q3 2018. Una gran parte di questi è stata ricondotta a pratiche di spam, attività che ha portato sulle bacheche 1,23 miliardi di elementi successivamente cancellati dal social network.

Per quanto concerne le nuove categorie introdotte, partiamo dal bullismo. Facebook sottolinea come in questi casi le segnalazioni degli utenti siano di fondamentale importanza, poiché si tratta spesso di contenuti che prendono di mira un soggetto specifico e non riconducibili a caratteristiche comuni. 2,1 milioni gli elementi rimossi, il 15% dei quali prima di ricevere un feedback. Via anche 8,7 milioni di elementi legati a una rappresentazione dei bambini non in linea con le policy: non solo contenuti pedopornografici o al limite della categoria, ma ad esempio (come riporta FB nel suo intervento) anche immagini innocenti di un piccolo nella vasca da bagno che se decontestualizzate potrebbero essere utilizzate in modo malevolo. In questo caso la percentuale degli elementi identificati in modo preventivo sale al 99%.

Le richieste dei governi

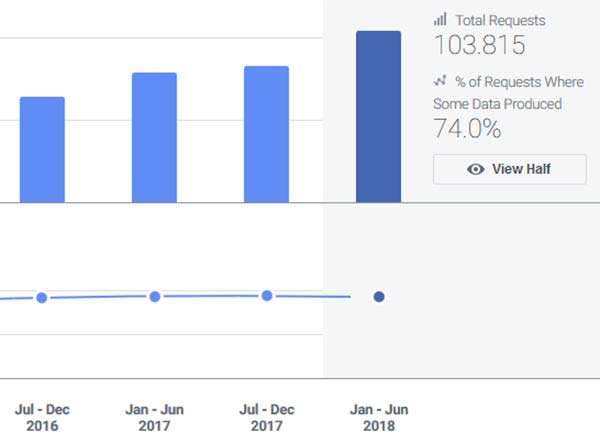

Un accenno anche alle richieste dei governi per l’accesso a dati degli utenti: sono cresciute del 26% circa tra la seconda metà del 2017 e la prima metà del 2018, da 82.341 a 103.815 (2.320 dall’Italia). Di queste, il 74% ha portato il social network a fornire le informazioni.

Il report si chiude con l’ammissione che il lavoro ancora da fare è molto. Gli algoritmi di machine learning e le soluzioni basate sull’intelligenza artificiale continueranno a costituire validi alleati per i team addetti alla moderazione. Un approccio che può contare anche sul contributo di realtà esterne come il Data Transparency Advisory Group.