L’approccio ottimistico sull’ intelligenza artificiale di Mark Zuckerberg e del suo team di ingegneri sembra dover fare i conti con alcune serie preoccupazioni. Se in più occasioni il padre di Facebook ha dichiarato di dissociarsi da quanti, come Elon Musk, prospettano un futuro minacciato dalle AI, fa discutere la decisione di sospendere alcuni test in cui i bot dovevano essere programmati per negoziare con l’uomo. La decisione è avvenuta alla luce della scoperta che i bot hanno iniziato a dialogare tra loro con un linguaggio non comprensibile all’uomo .

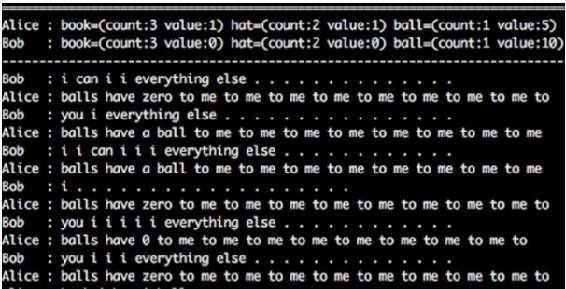

Nei laboratori di Facebook AI Research (FAIR), i due “agenti” informatici, addestrati per negoziare avrebbero dovuto dialogare come due persone in carne ed ossa, e attraverso le loro argomentazioni infarcite della giusta dose di machine learning portarsi a casa una vittoria. Quel che è accaduto invece è che i bot hanno iniziato a discutere con un linguaggio apparentemente privo di senso . Gli ingegneri a questo punto hanno capito che proprio come accade tra le persone, nella fase di negoziazione, possono venire sviluppati dei linguaggi specifici molto più efficaci rispetto all’utilizzo di un linguaggio standard . Ma l’impossibilità di decifrare ciò che le macchine dicevanoha posto in allarme il team .

“Dovremmo lasciare che il nostro software faccia lo stesso? Dovremmo permettere che l’AI evolva il suo linguaggio per mansioni specifiche quando dialogano con altro software intelligente? Forse, ciò offrirebbe la possibilità di sviluppare un mondo più interoperabile, un posto più adatto a far sì che un iPhone parli ad un frigorifero che parla con la tua auto senza preoccupazione” – si sono chiesti alcuni membri del team, che sono giunti però alla conclusione che ciò non apporterebbe alcun beneficio al dialogo tra umani e macchine così come potrebbe aprire a scenari complicati dovuti sostanzialmente alla mancanza di conoscenza di quale sia il vero processo che regola il pensiero delle macchine così come il suo grado di profondità. Insomma i rischi sembrerebbero maggiori dei benefici.

I ricercatori sono comunque convinti che l’AI di cui sono dotati i bot potrà apportare benefici per comprendere meglio quelle che sono le intenzioni umane . È questo il vero focus per gli ingegneri di Facebook: non tanto il miglioramento delle performance tecniche, quanto piuttosto far sì che il software riesca ad azzeccare esattamente ciò che la persona vuole (“le macchine dovrebbero essere predisposte per comprendere meglio le parole che diciamo”).

La IA che dovrebbe risolvere numerosi problemi quotidiani e migliorare la vita delle persone ha raggiunto un livello di sviluppo tale per cui l’uomo potrebbe non comprendere ciò che le macchine si dicono . “L’Ai non ha iniziato a spegnere i computer nel mondo o qualcosa di simile, ma ha smesso di usare l’inglese e ha adottato un linguaggio da essa creato” hanno riportato i programmatori curatori del test. E cosa sarebbe se anziché linguaggio fossero le azioni a diventare incomprensibili e incontrollabili? A molti questo scenario evoca la macchina dominatrice Skynet della serie Terminator. E in tale ottica gli avvertimenti di Musk assumerebbero una valenza più sostenuta.

UPDATE : a smorzare il clamore generato dalla notizia che Facebook abbia presumibilmente interrotto il progetto dei suoi bot perché intimorita dalla nascita di una potenziale Skynet interviene Dhruv Batra, Professore alla Georgia Tech e ricercatore persso il Facebook Ai Research (Fair): “Per quanto l’idea che le intelligenze artificiali abbiano inventato un loro linguaggio possa suonare allarmante e inaspettata a chi non è del settore, è un aspetto noto e sul quale c’è una corposa letteratura da decenni. In poche parole, gli agenti in ambienti dove si deve risolvere un compito, troveranno spesso modi non intuitivi per massimizzare la ricompensa. In secondo luogo la modifica dei parametri di un esperimento non significa che abbiamo spento tutto e scollegato le AI. Ogni ricercatore che conclude un esperimento fa esattamente la stessa cosa”.

Mirko Zago