Direttamente dai laboratori di Mountain View, ecco Gemini 2.0. È l’ultima evoluzione del modello di intelligenza artificiale addestrato da Google, il più capace stando a quanto si legge nell’annuncio, tale da compiere significativi passi in avanti sul fronte della multimodalità. Con questo ennesimo step, bigG inaugura ciò che definisce l’AI per l’era agenziale.

L’AI per l’era agenziale: arriva Gemini 2.0

La nuova versione offre il supporto nativo all’output di immagini e audio oltre a strumenti progettati per esperienze in grado di pianificare, ricordare e agire per voi, con la vostra guida

, come si legge nel comunicato giunto in redazione.

Di cosa si tratta, nel concreto? Google lo dimostra rilasciando alcuni prototipi ed esperimenti, al momento accessibili esclusivamente da un gruppo chiuso di tester.

Project Astra e gli altri esperimenti

Il primo è Project Astra, pensato per esplorare le capacità di un assistente AI universale. Avvistato a maggio in occasione dell’evento I/O 2024, è stato messo alla prova con successo su smartphone Android, ma presto troverà posto anche in dispositivi indossabili come gli occhiali smart.

C’è poi Project Mariner, un prototipo di ricerca strutturato in modo da sperimentare il futuro dell’interazione uomo-agente, all’interno del browser. Si tratta di un’estensione per Chrome capace di leggere e interpretare ogni elemento presente sullo schermo, dalle immagini ai moduli, per affiancare l’utente in ogni attività.

Jules è invece un agente di codifica destinato agli sviluppatori, ovviamente alimentato dall’intelligenza artificiale e che si integra direttamente nel flusso di lavoro di GitHub. Può prendere in carico un problema, proporre un piano e realizzarlo, sempre sotto la supervisione del responsabile.

Infine, Google ha realizzato che sfruttano le potenzialità del nuovo modello per navigare nel mondo virtuale dei videogiochi oppure in quello fisico, applicando le capacità di ragionamento spaziale alla robotica.

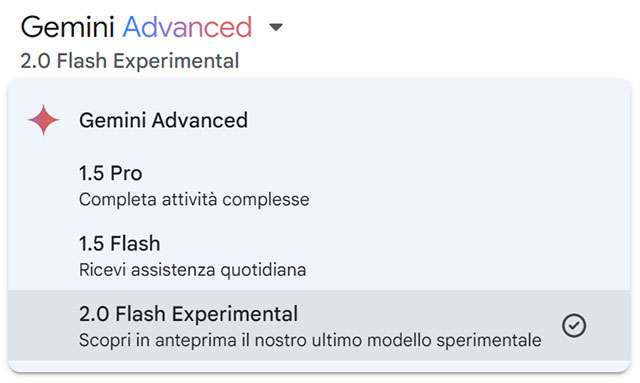

La versione Flash del modello Gemini 2.0

Il primo modello della famiglia, Gemini 2.0 Flash, è disponibile a partire da oggi nella sua forma sperimentale. È concepito per garantire prestazioni migliorate e bassa latenza. Lo si può selezionare nel menu nel menu a tendina, all’interno delle conversazioni con il chatbot, sia su desktop sia su app mobile. Gli sviluppatori possono iniziare fin da subito a fare leva sulle sue potenzialità attraverso l’API Gemini in Google AI Studio e Vertex AI.

Per gli utenti con accesso a Gemini Advanced, inoltre, è stata introdotta una nuova funzione chiamata Deep Research.

L’integrazione in AI Overviews per le ricerche

Chiudiamo segnalando che il comunicato fa riferimento anche all’integrazione di Gemini 2.0 in AI Overviews la funzionalità di ricerca potenziata dall’AI, non ancora disponibile in Italia. Questo permette, tra le altre cose, di rispondere a domande in più fasi, di risolvere equazioni matematiche avanzate, di far fronte a interrogazioni multimodali e a sfide di codifica.