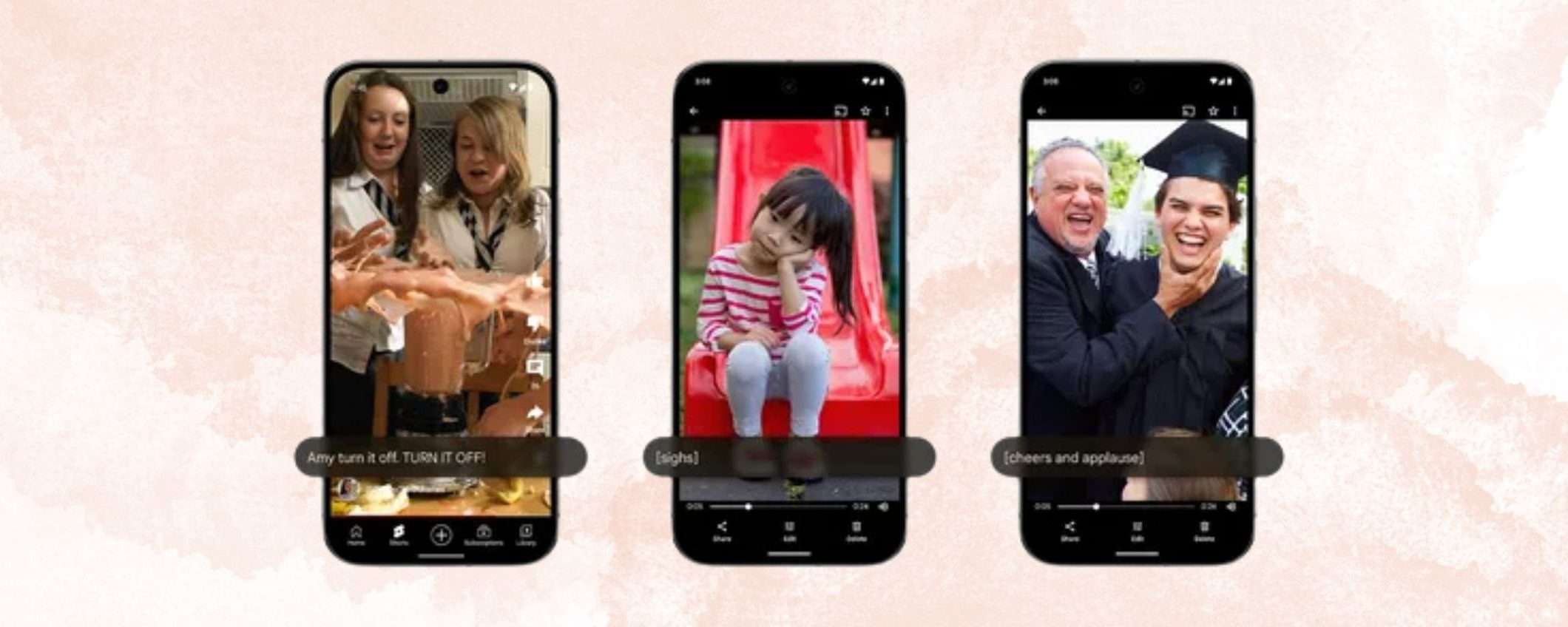

E se si potesse guardare un video e vedere comparire non solo i sottotitoli dei dialoghi, ma anche indicazioni su rumori ambientali [applausi], suoni onomatopeici [sigh] o ancora, cogliere l’intensità di un discorso con le maiuscole [BUON COMPLEANNO!], non sarebbe bello? Tutte quelle piccole cose che rendono la comunicazione molto più di semplici parole. È esattamente quello che faranno le nuove didascalie espressive di Android.

Su Android arrivano le didascalie espressive, l’intelligenza artificiale al servizio dell’accessibilità

Frutto della collaborazione tra i team di Android e Google DeepMind, le didascalie espressive (Expressive Captions) sfruttano l’AI per arricchire i sottotitoli con informazioni extra. Parole in maiuscolo per enfatizzare il tono di voce, etichette per suoni come sospiri e grugniti, indicazioni su rumori di sottofondo come gli applausi. Perché a volte sono proprio i dettagli a fare la differenza, soprattutto nei contenuti live e social che spesso non hanno sottotitoli precaricati di alta qualità.

Le didascalie espressive sono integrate nativamente in qualsiasi dispositivo Android con Live Caption che esegue Android 14 o versioni successive. Funzionano in tempo reale grazie all’elaborazione on-device, quindi non c’è bisogno di una connessione Internet. Si possono usare in qualsiasi app, dai video in streaming ai contenuti social, e restano attive anche in modalità aereo.

Disponibilità e lingue supportate

Per ora le didascalie espressive sono disponibili solo negli Stati Uniti e supportano esclusivamente la lingua inglese. Ma siamo sicuri che Google non si fermerà qui e presto questa interessante funzione sbarcherà anche in altri Paesi per abbracciare nuove lingue. Perché l’accessibilità non ha confini e merita sempre di essere messa al primo posto.