Siamo in una fase in cui tutti, anche se non addetti ai lavori, dobbiamo fare i conti con quella che potrebbe essere definita la democratizzazione dell’intelligenza artificiale. Sia chiaro, non che fino a oggi ogni nostra attività quotidiana non sia stata influenzata, guidata o semplificata (e talvolta complicata) dall’impiego, più o meno esplicito, più o meno volontario, di una qualche forma di algoritmo. Da molto tempo, ormai, lanciamo Netflix e ci troviamo di fronte a una lista di serie TV e film suggeriti sulla base delle nostre preferenze personali. Impostiamo il navigatore sullo smartphone e l’app ci consiglia un percorso alternativo per giungere a destinazione evitando una strada chiusa. Chiediamo ad Alexa, a Siri o all’Assistente Google che tempo farà domani e ci risponde con un linguaggio colloquiale.

Con un piede nell’era dell’IA generativa

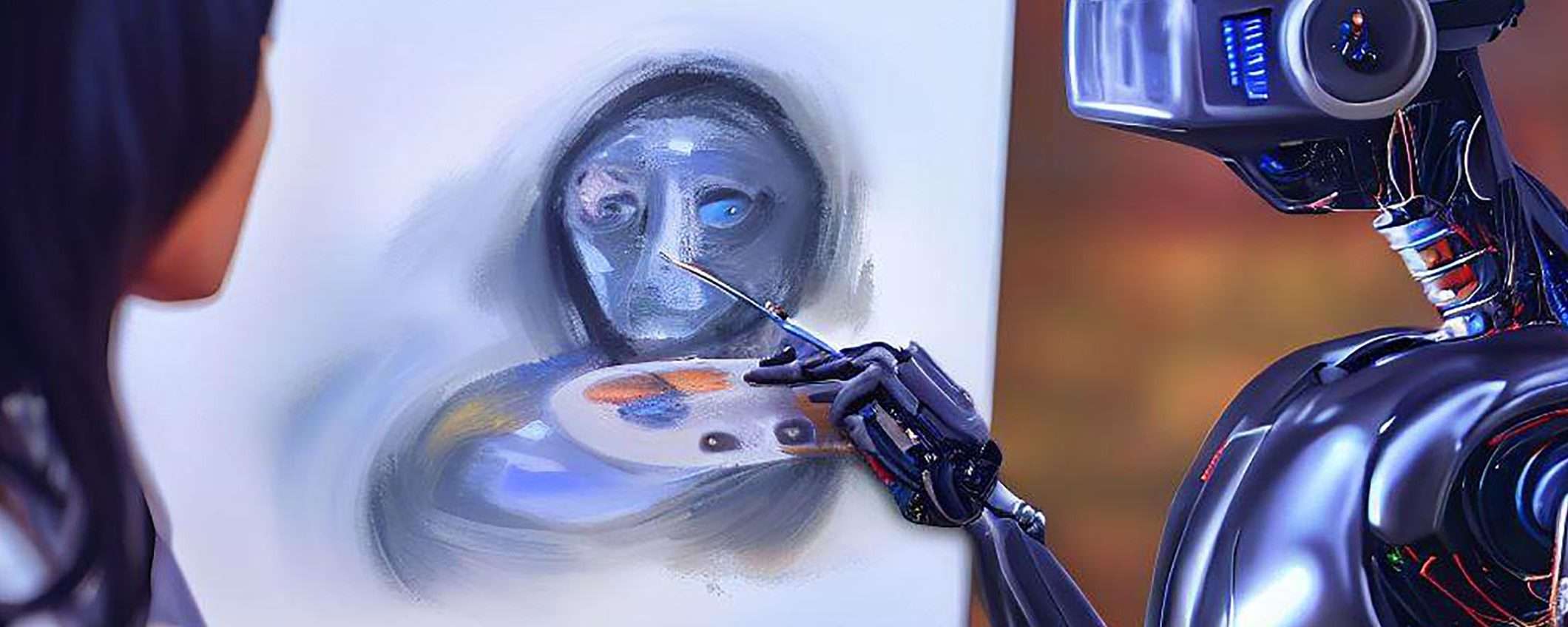

La novità è che, nell’ultimo periodo, il clamore suscitato dalla cosiddetta IA generativa, ci spinge a considerare la creazione automatizzata di un contenuto come qualcosa in grado di andare oltre le normali abilità di un software, più simile a un processo creativo che non all’esecuzione di semplici istruzioni codificate. Oggi possiamo aprire Bing Image Creator e digitare “Un maiale che vola sopra la Battersea Power Station di Londra”, ottenendo quanto segue (ogni riferimento all’opera pinkfloydiana è puramente voluto).

L’immagine è restituita in pochi secondi. Impressionante, no? Certamente è d’effetto e testimonia quanto le realtà impegnate su questo fronte abbiano compiuto passi da gigante nell’istruire i loro sistemi ad analizzare gli input ricevuti per poi produrre, in output, risultati convincenti. Si tratta dunque solo di questo? Di input e di output, con in mezzo una serie complessa di istruzioni eseguite in modo freddo e impersonale su un qualche server remoto? Oppure c’è di più?

Cos’è processo creativo, cos’è prodotto finale

Da qui si può partire per una riflessione su cosa sia processo creativo e su cosa sia prodotto finale. Il primo è forse quello dell’IA, mentre compone i pixel che infine formano l’immagine? Oppure è l’impegno di chi l’ha approntata, in un certo senso insegnandole a imparare, dandole poi in pasto enormi dataset utili a capire come posizionare un maiale in volo nel cielo sopra una ex centrale a carbone londinese, in modo coerente in termini di prospettiva e di illuminazione? E il secondo invece, il prodotto finale, è l’artwork generato o sono gli algoritmi che lo hanno mostrato sul nostro schermo?

Chiarire questa distinzione, ammesso che sia possibile farlo, può tornare utile per interpretare in quale direzione sta andando lo sviluppo dell’intelligenza artificiale generativa e quali possono essere i suoi impieghi, possibilmente virtuosi, al di là della soddisfazione che restituisce digitare una descrizione testuale e veder comparire una raffigurazione grafica di quanto scritto. E ci può aiutare anche a non averne paura, altro aspetto da non sottovalutare.

Le due facce della stessa medaglia

Il tema è tanto complesso quanto l’oggetto della riflessione stessa e si presta alle valutazioni e ai giudizi più differenti, ma va e andrà affrontato. Limitarsi a etichettare l’ascesa e la diffusione di queste soluzioni come un trend, secondo alcuni passeggero, non è utile né a comprendere il fenomeno né a intravederne le eventuali potenzialità.

Tutto questo senza considerare le implicazioni che l’evoluzione dei sistemi comporta dal punto di vista delle modalità impiegate per istruire i modelli e in relazione ai loro quasi inevitabili abusi. Ne abbiamo avuto una testimonianza oggi, con lo stop a ChatGPT imposto dal Garante nostrano per ragioni inerenti alla privacy (sebbene in questo caso la tecnologia sia in grado di creare testi e non immagini) e un’altra ieri, con la sospensione dell’accesso gratuito a Midjourney decisa dai suoi autori, a causa dell’enorme volume di deepfake riversato online.