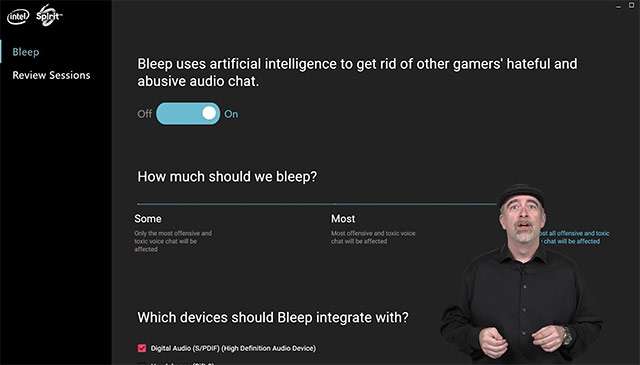

In occasione dell’evento virtuale GDC 2021 organizzato da Intel e andato in scena il mese scorso, la società ha citato la tecnologia Bleep basata sull’intelligenza artificiale e destinata al mondo del gaming: sostanzialmente un filtro per riconoscere e bloccare automaticamente insulti e termini offensivi scambiati tra i giocatori nelle chat vocali.

Intel Bleep: algoritmi come filtro per gli insulti

Agisce in locale, dunque sul PC di chi riceve il segnale audio proveniente dagli altri partecipanti alla conversazione. Permette all’utente di impostare diversi livelli restrittivi per differenti categorie di hate speech, agendo su slider (i valori sono None, Some, Most e All) relativi a contenuti come aggressioni verbali, odio nei confronti dei soggetti LGBTQ+, misoginia, attacchi diretti a qualcuno di specifico, razzismo e xenofobia, linguaggio sessualmente esplicito, “N-word”, blasfemie, suprematismo bianco e abilismo, la discriminazione nei confronti di persone con disabilità.

La tecnologia è rimasta in fase di sviluppo e test per circa un paio di anni, fin dal primo annuncio risalente al GDC 2019, coinvolgendo nel progetto il team di Spirit AI specializzato in soluzioni per la moderazione dei contenuti basate sull’impiego dell’intelligenza artificiale. Ora è quasi pronta al lancio. Queste le parole di Roger Chandler, VP e GM di Intel.

Siamo consapevoli che soluzioni come Bleep non eliminano il problema, ma crediamo sia un passo nella giusta direzione, per offrire ai giocatori uno strumento che consenta loro di esercitare controllo sull’esperienza.

La disponibilità è prevista entro la fine dell’anno. Quasi certamente e per ovvie ragioni, in un primo momento l’efficacia di Bleep sarà limitata alla sola lingua inglese. Non è nemmeno da escludere l’ipotesi di una compatibilità esclusiva con processori e hardware del gruppo di Santa Clara. L’efficacia della tecnologia è tutta da dimostrare.