L’intelligenza artificiale al servizio dell’accessibilità, attraverso una serie di iniziative che mirano a semplificare e rendere possibile l’interazione con informazioni e servizi da parte di coloro che incontrano ostacoli nell’utilizzo dei dispositivi tradizionali. Anche di questo si è parlato nel keynote di apertura dell’evento I/O 2019 in corso di svolgimento a Mountain View.

I/O 2019: Google, IA e accessibilità

Google ha annunciato un’iniziativa battezzata Project Euphonia il cui obiettivo è quello di impiegare algoritmi di riconoscimento vocale appositamente istruiti al fine di interpretare quanto pronunciato da chi soffre di disturbi del linguaggio per le ragioni più disparate, ad esempio in conseguenza all’insorgere di una patologia debilitante o neurodegenerativa.

Il progetto è stato messo in campo dal team che fa parte del programma AI for Social Good in collaborazione con organizzazioni non-profit come ALS Therapy Development Institute e ALS Residence Initiative. Lo scopo è quello di partire da un set di registrazioni vocali, frasi pronunciate dalle persone affette da un disturbo di questo tipo, così da identificare pattern e ricorrenze, per poi arrivare a elaborare un modello in grado di interpretare il flusso audio prodotto traducendolo in comandi, messaggi da inviare o frasi da impiegare durante le conversazioni.

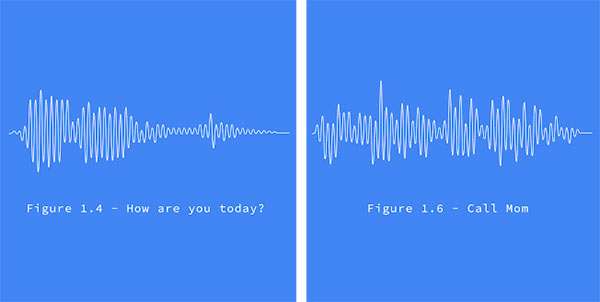

Sempre dal palco dell’I/O 2019 sono arrivati gli annunci di Live Caption e Live Relay. La prima è una tecnologia in grado di aggiungere in modo del tutto automatico e in tempo reale i sottotitoli a un video oppure a un podcast, convertendoli in una lingua diversa rispetto a quella originale se necessario. La seconda si occupa invece trascrivere le telefonate, in modo che la comunicazione possa avvenire tra una persona in grado di parlare e un’altra che invece può affidarsi alla scrittura dei messaggi, beneficiando inoltre di suggerimenti mirati mostrati dall’IA, come si può vedere nella demo allegata qui sotto.

Il debutto di Live Caption dovrebbe essere pressoché immediato, mentre Live Relay si trova al momento ancora in fase di sviluppo e potrebbe trascorrere diverso tempo prima di vedere la tecnologia debuttare su larga scala.