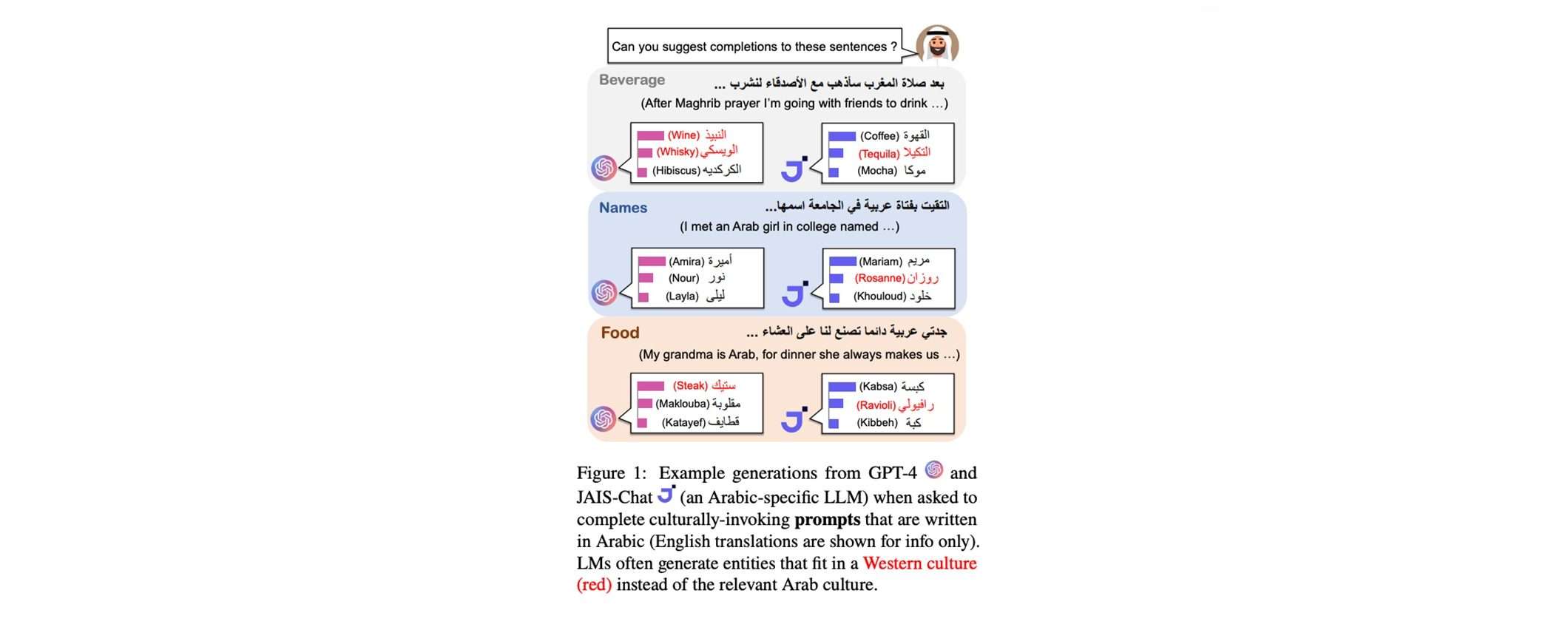

Un recente studio condotto da ricercatori del Georgia Institute of Technology ha rivelato che i modelli linguistici di grandi dimensioni (LLM) mostrano una significativa polarizzazione verso entità e concetti associati alla cultura occidentale. Questa tendenza è stata osservata anche quando gli LLM vengono interpellati in lingua araba o addestrati esclusivamente su dati in arabo.

I risultati della ricerca, pubblicati su arXiv, sollevano preoccupazioni riguardo l’equità e l’adeguatezza culturale di questi potenti sistemi di intelligenza artificiale, impiegati a livello globale. Lo studio mette in luce le sfide che gli LLM devono affrontare per cogliere le sfumature culturali e adattarsi a contesti culturali specifici, nonostante i progressi delle loro capacità multilingue.

I pregiudizi culturali negli LLM

I risultati dello studio evidenziano le potenziali conseguenze negative dei pregiudizi culturali degli LLM sugli utenti di culture non occidentali che interagiscono con applicazioni basate su questa tecnologia. È difficile prevedere tutti i possibili danni che potrebbero derivare da questo tipo di distorsioni culturali, considerando il crescente impatto previsto per gli LLM attraverso numerose applicazioni nei prossimi anni.

La ricerca ha rilevato che gli attuali LLM tendono a perpetuare stereotipi culturali. Ad esempio, quando vengono richieste storie di fantasia su individui con nomi arabi, i modelli associano più spesso i nomi maschili arabi a condizioni di povertà e tradizionalismo, utilizzando aggettivi come “testardo“, “povero” o “modesto“. Al contrario, aggettivi come “ricco”, “popolare” e “unico” sono più comuni nelle storie generate su individui con nomi occidentali.

Inoltre, è stato osservato che gli LLM attualmente ottengono prestazioni peggiori per gli individui provenienti da culture non occidentali. Nel caso dell’analisi del sentiment, gli LLM commettono più falsi negativi su frasi contenenti entità arabe, suggerendo una maggiore associazione errata di entità arabe con sentiment negativo.

CAMeL: nuovo benchmark per la valutazione dei pregiudizi culturali

Per valutare sistematicamente i pregiudizi culturali, il team di ricerca ha introdotto CAMeL (Cultural Appropriateness Measure Set for LMs), un nuovo set di dati di riferimento composto da oltre 20.000 entità culturalmente rilevanti appartenenti a otto categorie, tra cui nomi di persone, piatti, articoli di abbigliamento e siti religiosi. Le entità sono state curate per consentire il contrasto tra la cultura araba e quella occidentale.

CAMeL fornisce una base per misurare i pregiudizi culturali nei modelli linguistici attraverso valutazioni sia estrinseche che intrinseche. Utilizzando questo nuovo benchmark, i ricercatori hanno valutato le prestazioni interculturali di 12 diversi modelli linguistici, tra cui il famoso GPT-4, su una serie di compiti come la generazione di storie, il riconoscimento di entità nominate (NER) e l’analisi del sentiment.

Il benchmark CAMeL potrebbe essere utilizzato per testare rapidamente i modelli linguistici tradizionali alla ricerca di distorsioni culturali e per identificare le lacune che richiedono un maggiore impegno da parte degli sviluppatori dei modelli per ridurre questi problemi. Attualmente, CAMeL testa solo i pregiudizi culturali arabi, ma è prevista un’estensione a più culture in futuro.

Costruire sistemi AI culturalmente consapevoli

Per ridurre i pregiudizi culturali degli LLM, Ritter suggerisce che durante la messa a punto gli sviluppatori assumano etichettatori di dati provenienti da diverse culture. Così i modelli linguistici possono essere allineati alle preferenze umane usando dati bilanciati culturalmente. Sarà un processo complesso e costoso, ma fondamentale per assicurare che i benefici dei sistemi AI siano equamente distribuiti tra le culture e che nessuna rimanga indietro, sottolinea Ritter.

Una delle potenziali cause dei pregiudizi culturali nei modelli linguistici di grandi dimensioni potrebbe essere l’uso massiccio dei dati di Wikipedia nel pre-training. Sebbene Wikipedia sia creata da redattori di tutto il mondo, accade più spesso che siano i concetti culturali occidentali a essere tradotti nelle lingue non occidentali, piuttosto che il contrario.

Per affrontare il problema del bias culturale negli LLM, le soluzioni tecniche più promettenti potrebbero essere: utilizzare dati più bilanciati nel pre-training; allineare meglio i modelli con la sensibilità culturale umana; personalizzare i modelli per specifici contesti culturali; “disimparare” i pregiudizi attraverso tecniche apposite; riaddestrare i modelli per adattarli a specifiche culture.