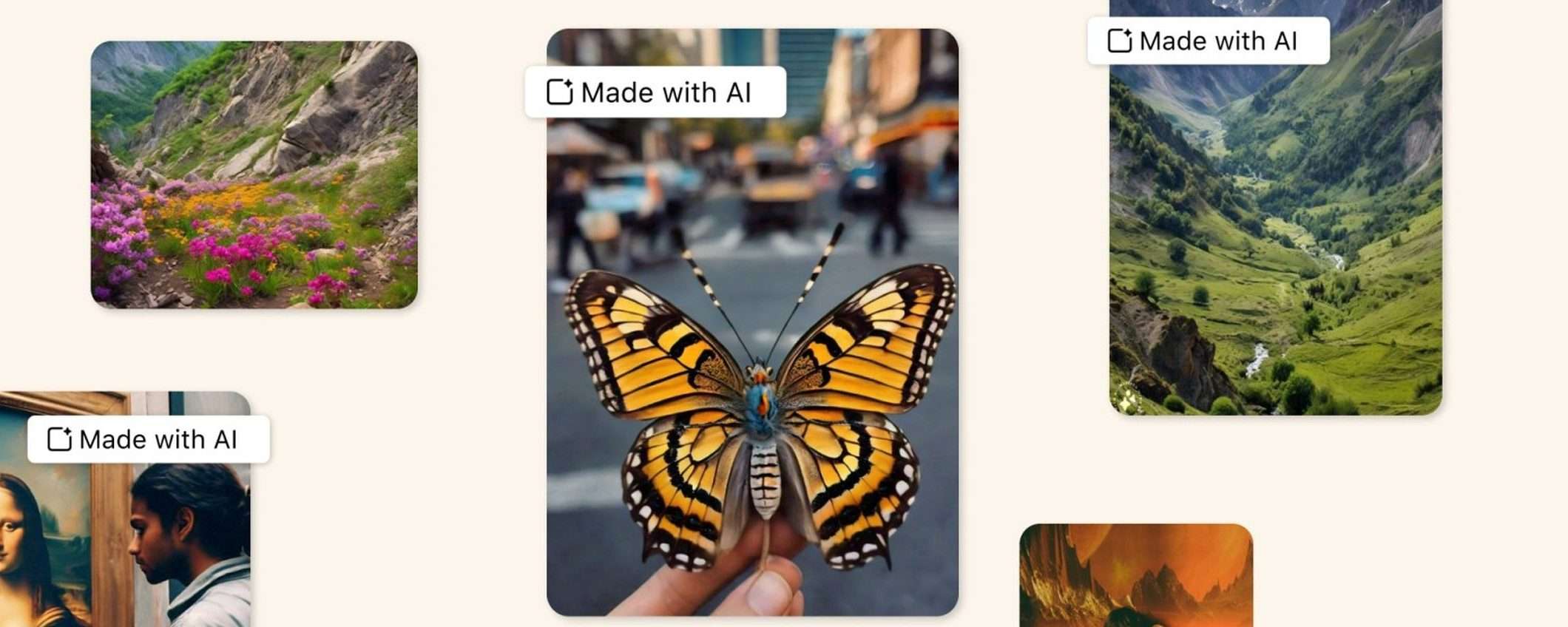

Dal mese di maggio, le foto generate con l’intelligenza artificiale sono chiaramente indicate sulle app di Facebook, Instagram e Threads. Molti utenti, tra cui fotografi professionisti, hanno notato che il sistema automatico non funziona. L’etichetta “Made with AI” viene infatti aggiunta anche alle foto reali scattate da un umano. Il problema sembra essere correlato all’uso dei software di editing.

Il tool di Meta non riconosce le foto reali

Le etichette sono state annunciate all’inizio di febbraio. Dal mese di aprile vengono aggiunte ad un numero maggiore di contenuti per limitare la diffusione dei deepfake. Il tool usato da Meta su Facebook, Instagram e Threads identifica le foto IA di terze parti attraverso i watermark invisibili basati sugli standard C2PA e IPTC.

Fotografi professionisti e semplici utenti hanno tuttavia evidenziato l’applicazione errata dell’etichetta “Made with AI“. Il caso più eclatante è quello segnalato da Eric Parè. Una sua foto pubblicata su Instagram è stata considerata opera dell’intelligenza artificiale. Il fotografo ha pubblicato anche l’immagine dello schermo della fotocamera per dimostrare che si tratta di una foto reale.

L’etichetta viene aggiunta automaticamente e non c’è nessuna opzione che consente la sua rimozione. Ciò può avere conseguenze negative per la reputazione dei fotografi e fornisce un’informazione errata agli utenti. In molti casi sembra che la colpa sia delle funzionalità IA di Adobe Photoshop, come quella per la cancellazione degli oggetti. In pratica, il tool di Meta non può distinguere se una foto è stata generata dall’IA o modificata con l’IA.

Alcuni fotografi affermano che l’etichetta viene correttamente aggiunta. In effetti, cliccando su “Made with AI“, si può leggere che l’IA generativa è stata usata per creare o modificare il contenuto. L’azienda di Menlo Park ha annunciato che apporterà miglioramenti in modo da considerare la quantità di IA usata nell’immagine.