I ricercatori di Meta AI hanno presentato MobileLLM, un innovativo approccio alla creazione di modelli linguistici efficienti progettati per smartphone e altri dispositivi con risorse limitate. Il lavoro mette in discussione le ipotesi sulle dimensioni necessarie per creare LLM efficaci.

Ottimizzazione di modelli con meno di 1 miliardo di parametri

Il team di ricerca, composto da membri di Meta Reality Labs, PyTorch e Meta AI Research (FAIR), si è concentrato sull’ottimizzazione di modelli con meno di 1 miliardo di parametri, una frazione delle dimensioni di modelli come GPT-4, che invece ha oltre un trilione di parametri. Yann LeCun, Chief AI Scientist di Meta, ha evidenziato gli aspetti chiave della ricerca su X.

MobileLLM: nice paper from @AIatMeta about running sub-billion LLMs on smartphones and other edge devices.

TL;DR: more depth, not width; shared matrices for token->embedding and embedding->token; shared weights between multiple transformer blocks;Paper: https://t.co/TDWQWdZeIy pic.twitter.com/3IBklvTiBI

— Yann LeCun (@ylecun) July 7, 2024

Ggli ingegneri di Meta hanno ottimizzato l’architettura del modello in modo da farla funzionare bene anche con meno potenza di calcolo. È un po’ come costruire un motore più compatto ed efficiente che consuma meno benzina. Questo modello AI compatto occupa quindi poco spazio e richiede meno potenza di elaborazione. Ciò lo rende perfetto per funzionare all’interno di dispositivi come gli smartphone, che hanno risorse hardware limitate rispetto a un computer.

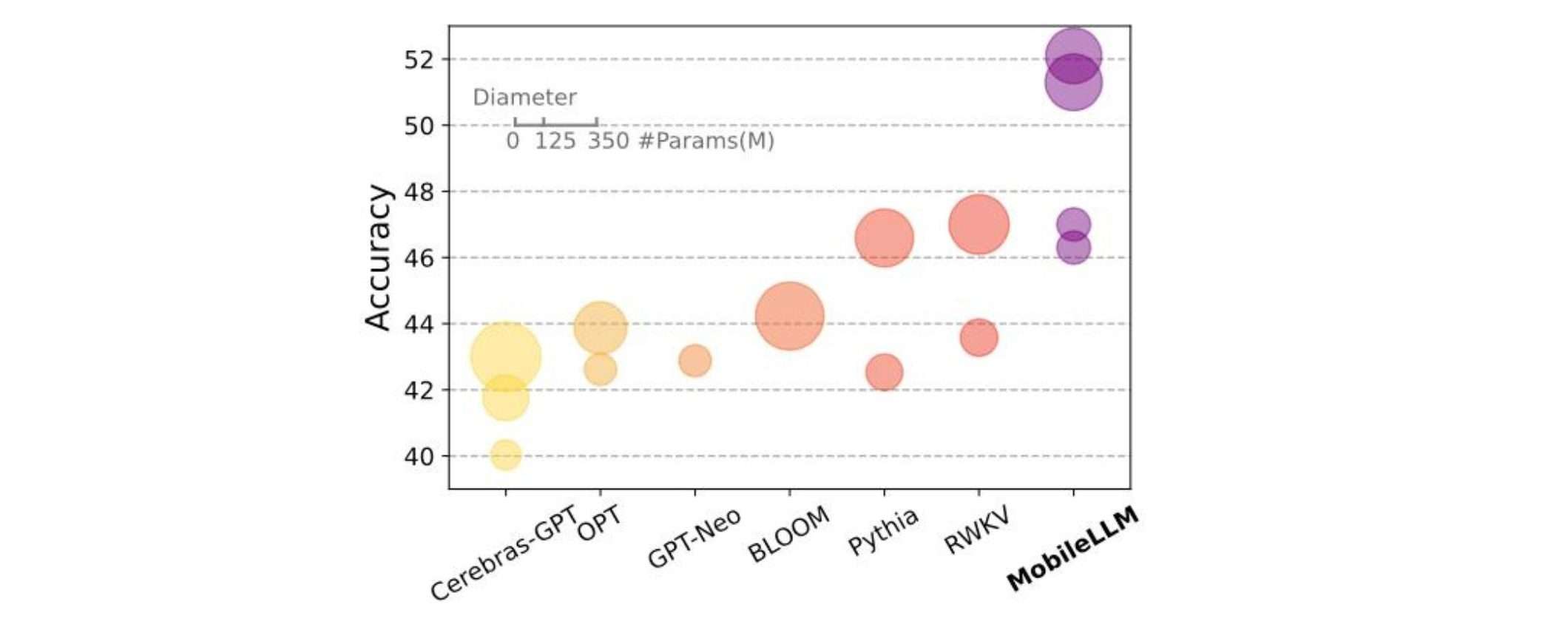

MobileLLM inoltre, ha ottenuto risultati migliori del 2,7-4,3% rispetto agli altri modelli a parità di dimensioni contenute, sviluppati da altre aziende.

Accuratezza paragonabile a modelli più grandi

La versione da 350 milioni di parametri di MobileLLM ha dimostrato un’accuratezza paragonabile a quella del modello Llama 2, molto più grande e da 7 miliardi di parametri, su alcuni compiti di chiamata API. Ciò suggerisce che, per alcune applicazioni specifiche, modelli più compatti potrebbero offrire funzionalità simili pur utilizzando risorse computazionali significativamente inferiori.

Disponibilità di MobileLLM

Lo sviluppo di MobileLLM è in linea con il crescente interesse per modelli AI più efficienti, ma anche più compatti e specializzati, i cosiddetti “Small Language Models” (SLM). Sebbene MobileLLM non sia ancora disponibile per l’uso pubblico, Meta ha reso disponibile il codice di pre-addestramento, consentendo ad altri ricercatori di sviluppare il proprio lavoro.