Apple ha annunciato il rilascio di un nuovo modello AI open-source, chiamato “MGIE”, che permette di modificare le immagini sulla base di istruzioni in linguaggio naturale fornite dall’utente. Il modello, frutto di una collaborazione tra Apple e l’Università della California, Santa Barbara, è stato presentato alla International Conference on Learning Representations (ICLR) 2024, una prestigiosa conferenza di ricerca sull’intelligenza artificiale.

Le caratteristiche di MGIE

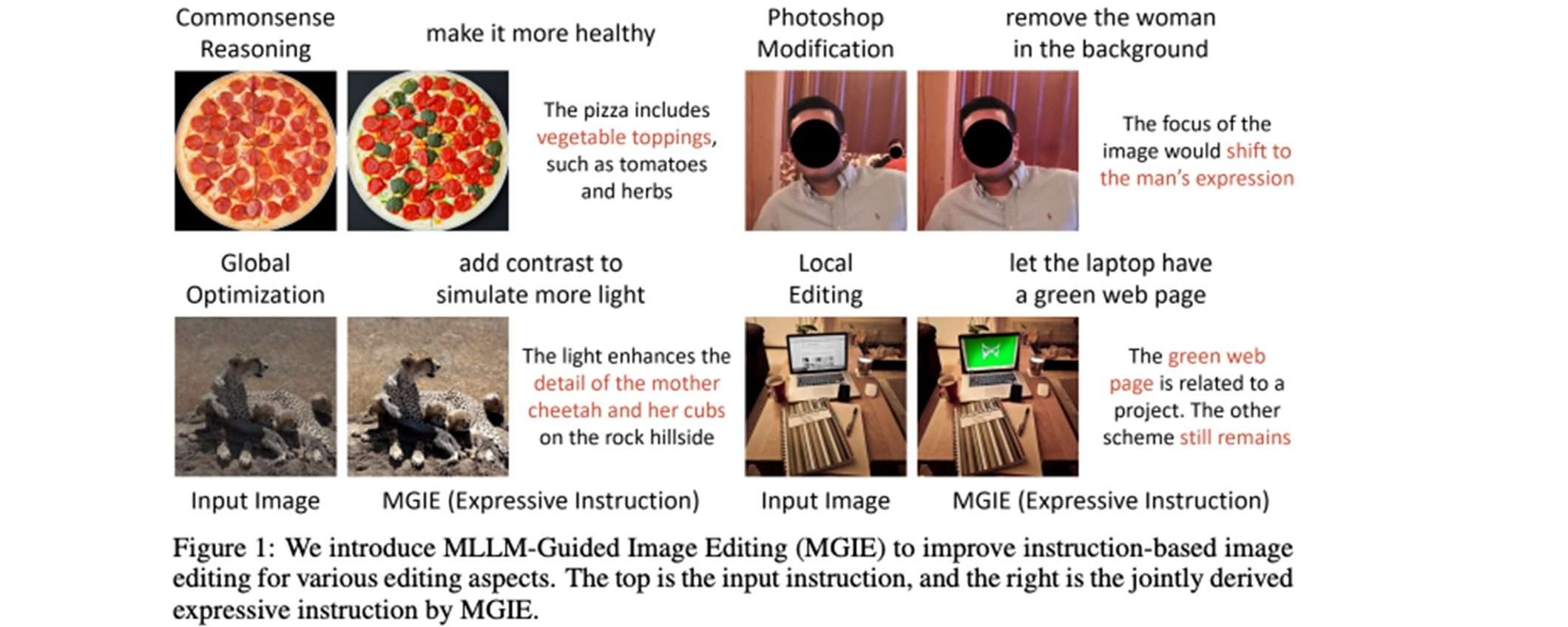

MGIE, acronimo di MLLM-Guided Image Editing, utilizza modelli linguistici multimodali di grandi dimensioni (MLLM) per interpretare le richieste dell’utente e tradurre i prompt dell’utente in modifiche a livello di pixel. Il modello è in grado di gestire vari aspetti dell’editing, come la modifica in stile Photoshop, l’ottimizzazione globale delle foto e modifiche localizzate. Il modello si dimostra efficace nel migliorare sia le metriche di valutazione automatica che la soddisfazione degli utenti, mantenendo un’elevata efficienza computazionale.

Come funziona MGIE di Apple

MGIE utilizza modelli linguistici multimodali di grandi dimensioni (MLLM) che possono elaborare sia testo che immagini, per potenziare l’editing di immagini guidato da istruzioni testuali. Gli MLLM hanno dimostrato capacità impressionanti di comprensione cross-modale e di generazione di risposte visivamente consapevoli. Tuttavia, non sono stati ancora ampiamente applicati al campo dell’editing di immagini.

MGIE integra i modelli linguistici multimodali di grandi dimensioni nel processo di modifica delle immagini in due modi. Innanzitutto, utilizza gli MLLM per estrarre istruzioni chiare e concise dall’input fornito dall’utente in linguaggio naturale. Ad esempio, dato l’input “rendere il cielo più blu“, MGIE può generare l’istruzione “aumentare la saturazione della zona cielo del 20%“.

In secondo luogo, sfrutta le capacità di elaborazione multimodale degli MLLM per tradurre queste istruzioni in modifiche effettive a livello di pixel dell’immagine, alterando parametri come saturazione, luminosità e contrasto nelle aree indicate. In questo modo MGIE guida il processo di modifica delle immagini in modo più efficiente e mirato rispetto all’input originale.