Microsoft ha realizzato un supercomputer per ChatGPT, spendendo diverse centinaia di milioni di dollari, come parte dell’accordo sottoscritto nel 2019 con OpenAI. L’azienda di Redmond ha utilizzato migliaia di GPU NVIDIA per fornire la potenza di calcolo necessaria all’addestramento dell’intelligenza artificiale. Non è noto però quanta energia viene consumata.

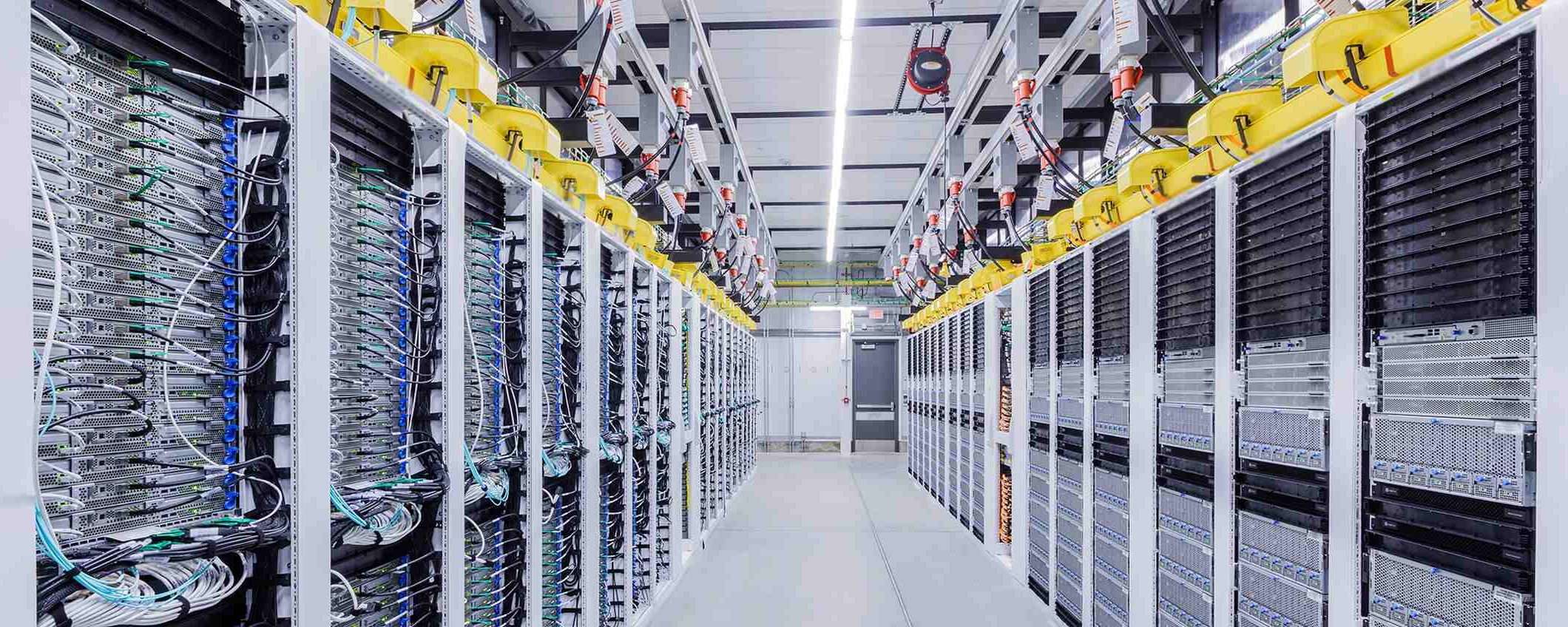

Supercomputer Microsoft per ChatGPT

Microsoft sviluppa da molti anni modelli IA per le sue applicazioni, quindi aggiorna costantemente l’infrastruttura cloud di Azure. Tuttavia, il modello GPT-3.5 di OpenAI richiede una maggiore potenza di calcolo non disponibile all’epoca (2019). L’azienda di Redmond ha quindi progettato e realizzato un supercomputer per ChatGPT e Prometheus, la versione personalizzata alla base di Bing Chat.

Per velocizzare l’addestramento di grandi modelli IA, come quello di OpenAI, sono necessarie numerose GPU in parallelo. Microsoft ha utilizzato migliaia di NVIDIA A100 collegate tra loro mediante un collegamento NVIDIA Quantum InfiniBand. Il supercomputer è stato recentemente aggiornato con GPU NVIDIA H100 interconnesse tra loro con NVIDIA Quantum-2 InfiniBand.

Ogni macchina virtuale ND H100 v5 sfrutta 8 GPU NVIDIA H100, 4 processori Intel Xeon Scalable e memoria DDR5 a 4.800 MHz. Il carico di lavoro viene partizionato tra migliaia di GPU in un cluster. Lo scambio dei dati avviene tramite la rete InfiniBand. È possibile aggiungere GPU ai cluster e potenziare la rete InfiniBand. Grazie a varie tecniche software, Microsoft può addestrare modelli IA con decine di trilioni di parametri.

Ovviamente è necessario un adeguato sistema di raffreddamento e un’alimentazione senza interruzioni con generatori di backup. Non sono noti l’energia elettrica consumata e il tipo di fonte utilizzata. Secondo una ricercatrice, per addestrare GPT-3 servirebbero 1.287 MWh, ovvero l’elettricità consumata da 120 abitazioni in un anno.