I ricercatori di Wiz hanno scoperto che il team Microsoft AI ha divulgato oltre 38 TB di dati privati su GitHub, inclusi i backup dei dischi di due dipendenti. I file sono stati erroneamente condivisi da account Azure Storage con la funzionalità SAS token. L’azienda di Redmond ha comunicato che i dati degli utenti non sono stati esposti.

Microsoft pubblica 38 TB di dati privati

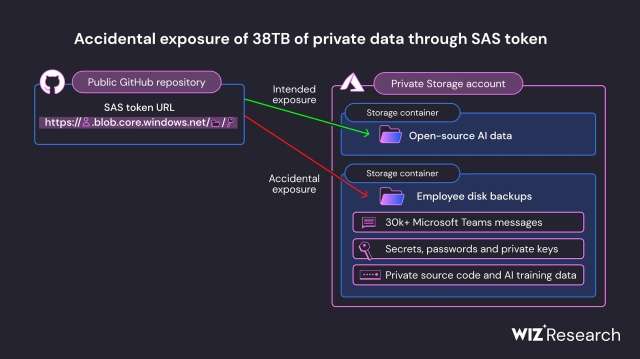

A partire da giugno 2020, il team di Microsoft AI ha pubblicato su GitHub il codice open source e i modelli AI per il riconoscimento delle immagini. Per scaricare il codice è stato fornito un URL di Azure Storage, ma l’indirizzo ha permesso l’accesso a 38 TB di dati, tra cui i backup dei dipendenti che contenevano password, chiavi private e oltre 30.000 messaggi interni scambiati con Microsoft Teams.

Il problema di sicurezza è stato causato dall’errata configurazione dei permessi. Per la condivisione del link allo storage di Azure è stato usato un token SAS (Shared Access Signature). Invece di consentire l’accesso ai file in sola lettura, Microsoft ha concesso il controllo totale dell’account di storage. Un malintenzionato poteva accedere a tutti i file (non solo quelli dei modelli IA), sovrascriverli e cancellarli. Inoltre, la scadenza del token era stata impostata al 2051.

I ricercatori di Wiz hanno segnalato il problema il 22 giugno. Microsoft ha invalidato il token due giorni dopo. Al termine dell’indagine, l’azienda di Redmond ha confermato che i dati degli utenti non sono stati compromessi. GitHub effettua la scansione dei repository per individuare eventuali password in chiaro, chiavi private e token SAS. Il token per l’accesso allo storage Azure era stato considerato un falso positivo. Il bug è stato corretto.