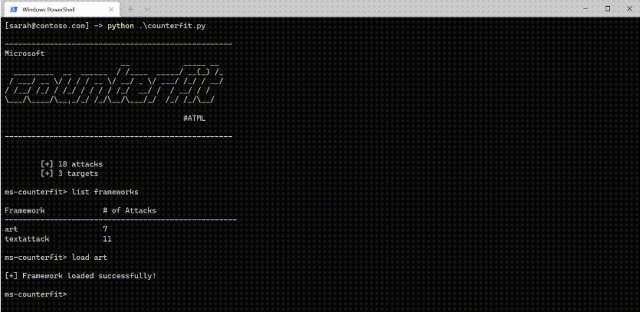

Microsoft ha rilasciato un tool automatico a linea di comando per la valutazione della sicurezza dei sistemi di intelligenza artificiale. Counterfit, offerto con licenza open source (il codice è disponibile su GitHub), permette di verificare la robustezza e l’affidabilità degli algoritmi di machine learning.

Microsoft Counterfit: test per sistemi IA

L’uso dei sistemi IA è in aumento in diversi settori, tra cui sanità, finanza e difesa. È quindi necessario garantire la massima protezione contro eventuali attacchi informatici. La valutazione della sicurezza per i sistemi IA non è un’attività semplice. In base ai risultati di sondaggio effettuato da Microsoft, la maggioranza delle organizzazioni interpellate (25 su 28) ha risposto di non avere tool specifici.

Counterfit è stato sviluppato dall’azienda di Redmond per i suoi sistemi IA come strumento proattivo. Attraverso una serie di script Python sono stati simulati attacchi contro singoli modelli IA. Successivamente il tool è stato automatizzato per attaccare più modelli IA su larga scala. Counterfit può essere utilizzato anche per rilevare in anticipo eventuali vulnerabilità.

Il tool è completamente “agnostico“, quindi funziona con qualsiasi ambiente (cloud, on-premises, edge), modello IA e tipo di dati (testo, immagini, input generico). Oltre che per rilevare le vulnerabilità, Counterfit può essere sfruttato come penetration test e per registrare gli attacchi e utilizzare la telemetria per migliorare la sicurezza dei sistemi IA. Tutti i dettagli su installazione, configurazione e uso sono disponibili su GitHub.