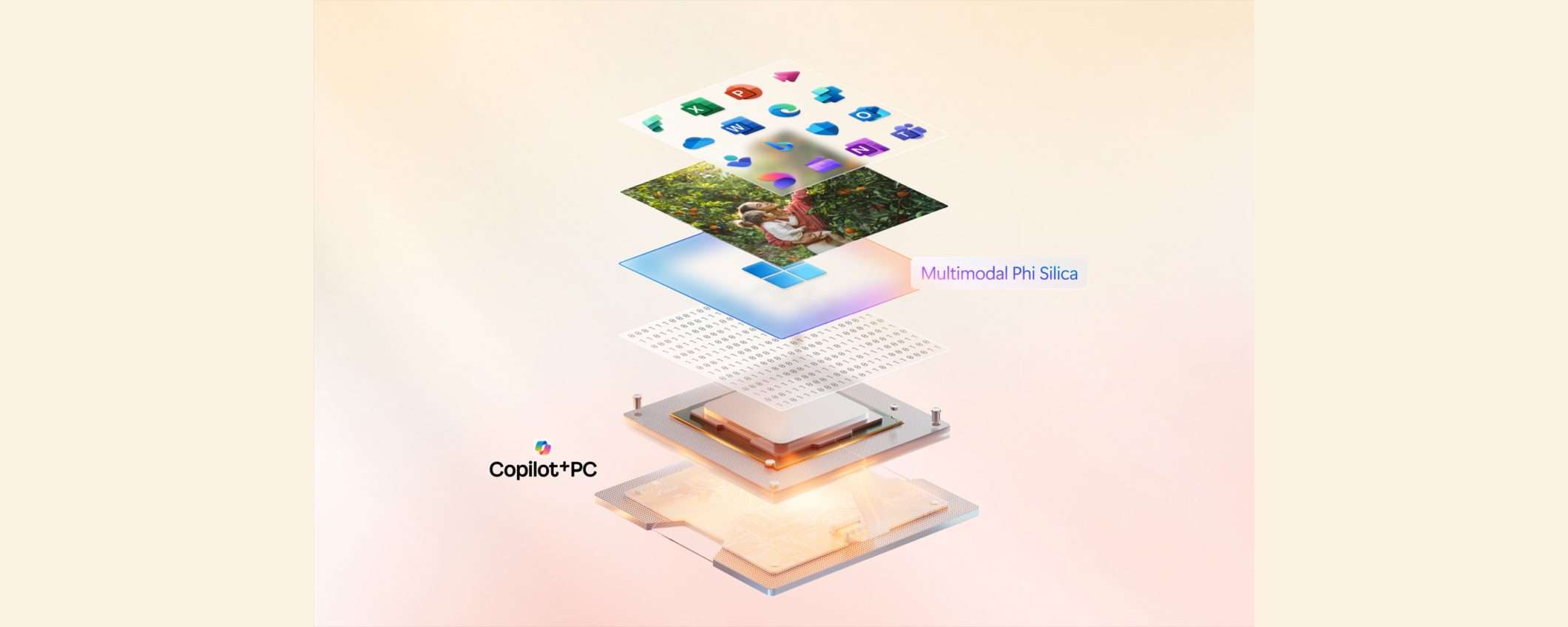

Microsoft ha annunciato che Phi Silica è diventato multimodale. Lo Small Language Model (SLM) viene sfruttato dai Copilot+ PC per eseguire diverse azioni direttamente sul dispositivo senza nessuna connessione ad Internet. L’azienda di Redmond ha aggiunto il riconoscimento delle immagini per la funzionalità Click to Do e l’assistente vocale.

Phi Silica diventa multimodale

Phi Silica viene utilizzato per varie funzionalità AI, tra cui la generazione di riassunti e i sottotitoli con traduzione in tempo reale per contenuti audio e video. Invece di aggiornare completamente il modello, Microsoft ha aggiunto solo la “capacità visiva” con un vision encoder basato su Florence, la tecnologia di computer vision usata da Recall e la versione potenziata di Windows Search.

Ciò ha permesso di mantenere bassa l’occupazione di spazio su disco e l’uso delle risorse (memoria e NPU). La multimodalità è attualmente supportata solo dai Copilot+ PC con processori Qualcomm Snapdragon X. Phi Silica può dunque analizzare le immagini e fornire una descrizione testuale. Questa è una demo pubblicata da Microsoft:

La nuova capacità del modello viene sfruttata per migliorare l’accessibilità. L’assistente vocale (Narrator) di Windows 11 può generare una breve descrizione (Alt Text) delle immagini utilizzando modelli cloud. Grazie a Phi Silica, la generazione avviene localmente e la descrizione è più dettagliata, come si vede nella seguente demo:

Al momento è supportato solo l’inglese. Altre lingue verranno aggiunte in seguito. La descrizione breve (circa 135 caratteri) viene generata in circa 4 secondi, mentre quella lunga (400-450 caratteri) viene generata in circa 7 secondi. Microsoft ha inoltre migliorato i filtri per evitare output inappropriati o pericolosi.