Microsoft ha presentato Azure AI Content Safety, un servizio progettato per identificare e gestire i contenuti inappropriati o potenzialmente pericolosi generati dagli utenti e dall’intelligenza artificiale all’interno di applicazioni e servizi.

Questo servizio offre API dedicate sia per il testo che per le immagini, consentendo agli sviluppatori di individuare e filtrare il materiale indesiderato in modo efficiente.

Azure AI Content Safety di Microsoft rileva e corregge le allucinazioni in tempo reale

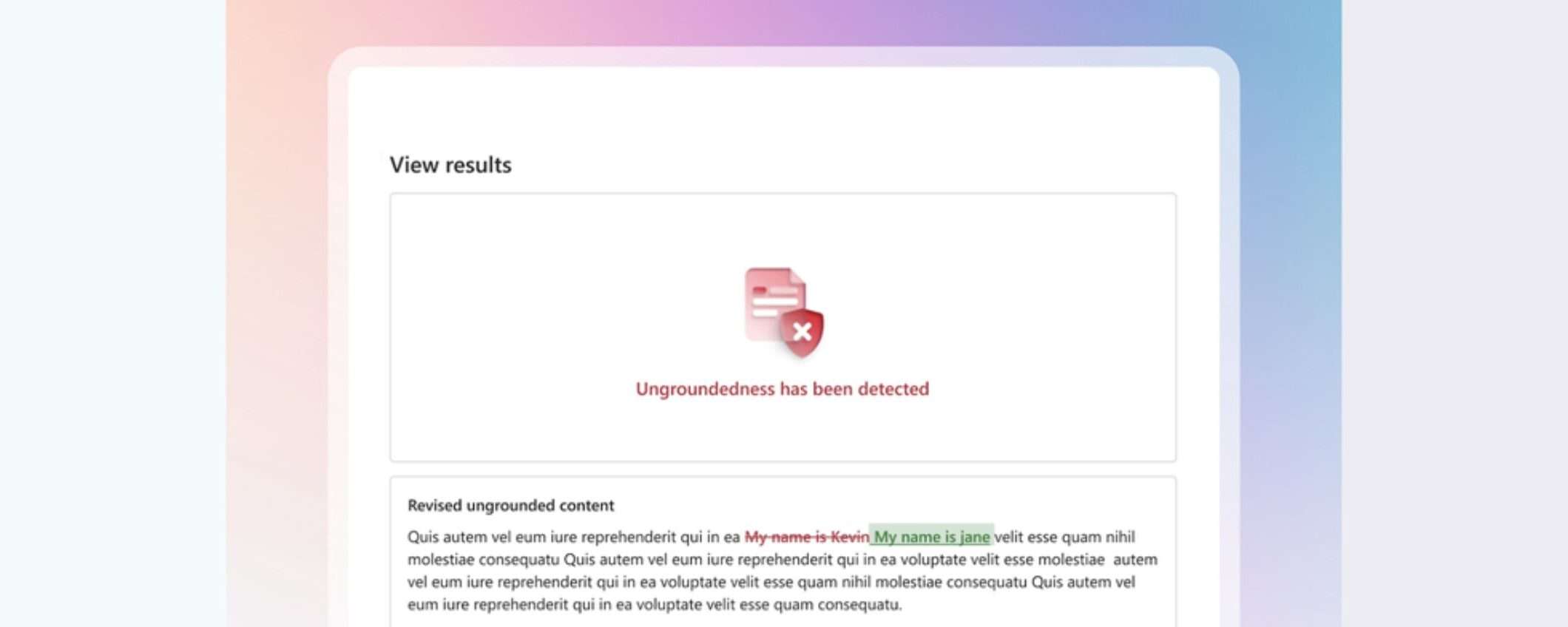

Una delle funzionalità chiave di Azure AI Content Safety è l’API di rilevamento della fondatezza, che permette di determinare se le risposte fornite dai modelli linguistici di grandi dimensioni sono basate su materiali di origine selezionati dall’utente. Poiché gli attuali LLM possono talvolta generare informazioni imprecise o non reali, definite “allucinazioni“, questa API si rivela uno strumento prezioso per gli sviluppatori nel processo di identificazione di tali contenuti.

Inoltre, Microsoft ha annunciato l’anteprima di una funzionalità che consente di correggere in tempo reale le allucinazioni presenti nei risultati dell’AI, garantendo agli utenti finali contenuti sempre accurati. Quando viene individuata una frase non fondata, il sistema invia una nuova richiesta di correzione al modello generativo dell’AI, che valuta la frase rispetto al documento di riferimento e, se necessario, la riscrive per allinearla alle informazioni contenute nel documento stesso.

Implementazione ibrida e rilevamento di materiali protetti nel codice generato dall’AI

Oltre alla funzione di correzione, Microsoft ha annunciato l’anteprima pubblica di Azure AI Content Safety ibrido, che permette agli sviluppatori di implementare meccanismi di sicurezza dei contenuti sia nel cloud che sui dispositivi. Grazie all’Embedded SDK di AACS, è possibile effettuare controlli in tempo reale sulla sicurezza dei contenuti direttamente sui dispositivi, anche in assenza di connettività Internet.

Un’altra novità è l’anteprima di Protected Materials Detection for Code, utilizzabile con le applicazioni AI che producono codice per rilevare se l’LLM ha generato codice protetto. Precedentemente disponibile solo tramite Azure OpenAI Service, questa funzione è ora accessibile ai clienti per l’utilizzo in combinazione con altri modelli di AI generativi che generano codice.