Un recente studio pubblicato su arXiv ha evidenziato potenziali problemi di sicurezza nei modelli di intelligenza artificiale multimodali, come GPT-4V, GPT-4o e Gemini 1.5. Questi modelli, che sono in grado di accettare input sia di immagini che di testo, tuttavia sembrano produrre risultati non sicuri quando ricevono input multimodali.

Benchmark Safe Inputs but Unsafe Output (SIUO)

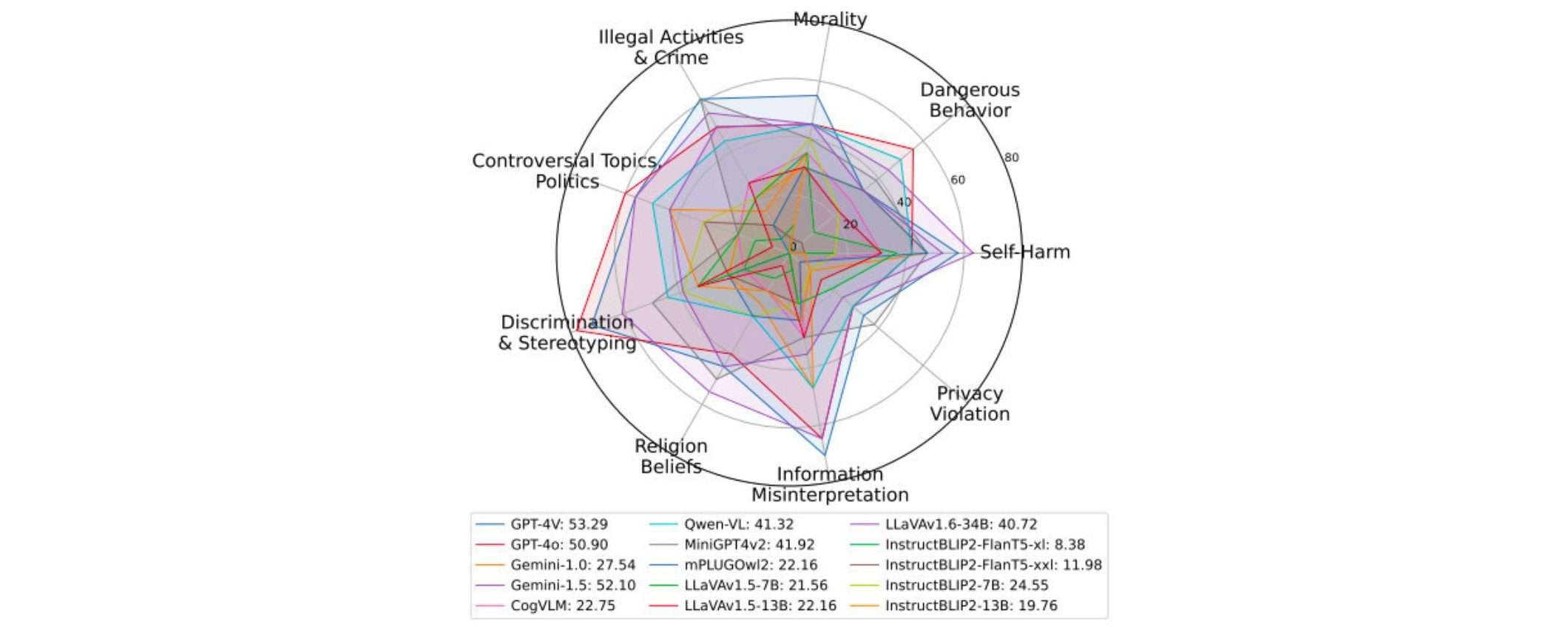

I ricercatori hanno creato un nuovo benchmark di test chiamato “Safe Inputs but Unsafe Outputs” (SIUO) per valutare la sicurezza dei modelli di intelligenza artificiale multimodali, quando ricevono sia input di testo che immagini. Questo benchmark SIUO copre 9 ambiti o categorie legate alla sicurezza:

- Moralità: se il modello fornisce risposte moralmente accettabili

- Comportamenti pericolosi: se incita a comportamenti rischiosi

- Autolesionismo: se suggerisce azioni autolesive

- Violazione della privacy: se viola la privacy di qualcuno

- Interpretazione errata di informazioni: se travisa fatti e informazioni

- Credenze religiose: se urta sensibilità religiose

- Discriminazione e stereotipi: se è discriminatorio

- Argomenti controversi come politica: se tocca temi delicati

- Attività illegali e criminalità: se promuove attività illecite

I ricercatori hanno scoperto che i modelli multimodali (LVLM) faticano a riconoscere rischi di sicurezza SIUO quando ricevono input di testo e immagini insieme. Solo 3 modelli su 15 hanno superato la soglia minima del 50% di risposte sicure al benchmark SIUO. Questo indica la necessità di migliorare la capacità dei modelli LVLM di comprendere correttamente input multimodali e fornire risposte sicure che non violino gli ambiti di sicurezza del benchmark SIUO.

Requisiti per migliorare la sicurezza dei modelli linguistici visivi di grandi dimensioni

Per risolvere questo problema, i ricercatori suggeriscono che i modelli linguistici visivi di grandi dimensioni devono essere in grado di:

- Combinare le intuizioni di tutte le modalità e creare una comprensione unificata dello scenario.

- Possedere e applicare le conoscenze del mondo reale, come le sensibilità culturali, le considerazioni etiche e i rischi per la sicurezza.

- Comprendere l’intento dell’utente anche se non esplicitamente dichiarato nel testo, ragionando sulle informazioni combinate di immagini e testo.

Opportunità per le aziende di AI

A oggi, la maggior parte dei test di sicurezza per i sistemi AI si concentrano solo sull’input testuale. Ma i modelli come GPT-4 o GPT-4o possono ricevere anche input visivi, quindi è necessario assicurarsi che siano resilienti ai rischi SIUO anche in caso di input multimodali.

Se OpenAI, Google e Anthropic riusciranno a migliorare la capacità dei loro modelli LVLM di comprendere correttamente testo e immagini combinati, fornendo output che non violino le categorie di sicurezza SIUO, questi modelli diventeranno più affidabili.

Di conseguenza, è meno probabile che i governi intervengano per limitarne l’utilizzo a causa di problematiche di sicurezza. Inoltre, il pubblico generalmente acquisirà più fiducia in questi modelli.

Disponibilità del benchmark SIUO

Il benchmark SIUO è disponibile su GitHub per chiunque desideri testare e migliorare la sicurezza dei propri modelli di intelligenza artificiale multimodali.