I ricercatori di Amazon hanno creato il più grande modello di text-to-speech mai realizzato finora. Secondo loro, questo modello presenta qualità “emergenti”, migliorando notevolmente la capacità di pronunciare in modo naturale anche frasi complesse.

In genere, all’aumentare delle dimensioni questi modelli tendono a migliorare, ma i ricercatori speravano di osservare quel salto di qualità che si verifica quando i modelli linguistici superano una certa soglia. Per ragioni ancora poco chiare, dopo un certo punto gli LLM diventano molto più robusti e versatili, capaci di svolgere compiti per cui non erano stati addestrati.

Ciò non implica che stiano diventando senzienti, ma solo che le loro prestazioni in determinati compiti di intelligenza artificiale conversazionale migliorano significativamente. Il team di Amazon ritiene che la stessa cosa possa accadere con l’aumento delle dimensioni dei modelli text-to-speech, e i loro risultati sembrano confermarlo.

Sintesi vocale più naturale con il modello BASE TTS di Amazon

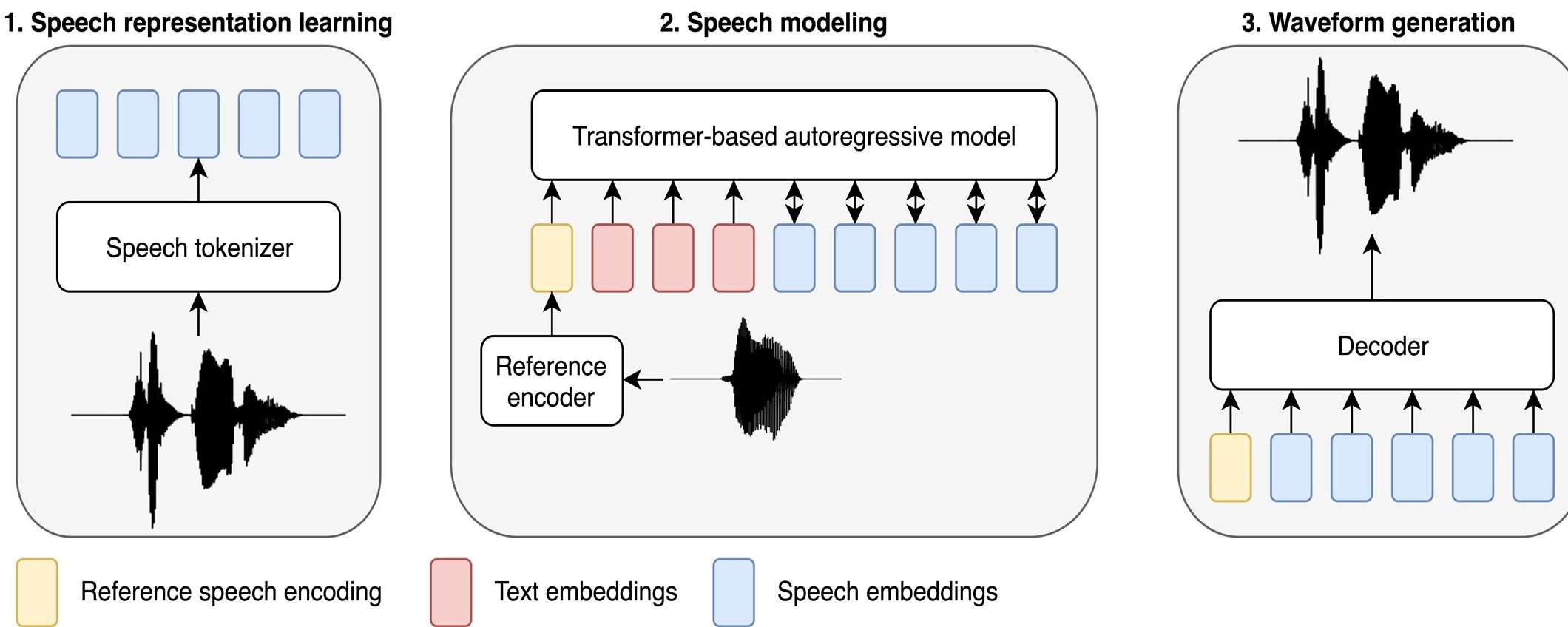

Il nuovo modello si chiama BASE TTS (Big Adaptive Streamable TTS with Emergent abilities) e nella sua versione più grande utilizza 100.000 ore di registrazioni vocali di dominio pubblico, per il 90% in inglese e il resto in tedesco, olandese e spagnolo.

La versione più grande del modello, chiamata BASE-large, ha 980 milioni di parametri, il che lo rende il modello più grande di questa categoria. Per confronto, sono stati addestrati anche modelli più piccoli, da 400 e 150 milioni di parametri, basati su 10.000 e 1.000 ore di audio rispettivamente. L’obiettivo era di capire se la dimensione del modello influisce sulle abilità emergenti, cioè quelle capacità che il modello mostra senza averle apprese direttamente.

Le abilità emergenti di BASE TTS

Il modello di dimensione media, chiamato BASE-medium, ha dimostrato di avere le abilità emergenti che i ricercatori cercavano. Queste abilità non riguardano solo la qualità del parlato ordinario, che è migliorata di qualche punto rispetto ai modelli precedenti, ma anche la capacità di gestire testi difficili, che presentano sfide linguistiche e paralinguistiche. Nel documento che presenta il modello, gli autori hanno fornito alcuni esempi di questi testi difficili, che includono sostantivi composti, emozioni, parole straniere, fenomeni paralinguistici (es. shh, fai silenzio), punteggiatura, domande, ecc.

Questi test richiedono al modello BASE TTS di analizzare frasi complesse, porre l’accento nel modo corretto su parole lunghe, produrre toni emotivi o sussurrati, e pronunciare correttamente termini stranieri o simboli come “@” – tutti compiti per cui non era stato addestrato esplicitamente.

I motori di sintesi vocale tradizionali fanno fatica a gestire questi testi, e commettono errori di pronuncia, saltano parole, usano un’intonazione innaturale, ecc. BASE TTS ha ancora qualche problema, ma ha superato di gran lunga i suoi concorrenti, come i modelli Tortoise e VALL-E.

Sul sito dedicato al nuovo modello, si possono ascoltare alcuni esempi di testi difficili pronunciati in modo naturale da BASE TTS. Si tratta di esempi selezionati dai ricercatori, quindi non sono rappresentativi di tutti i casi possibili, ma sono comunque impressionanti. Bisogna tenere presente che si tratta di un modello e di un processo sperimentale, non di un prodotto commerciale o altro.

Un modello streamable

Una caratteristica interessante di questo modello è che è “streamable”, come suggerisce il nome. Questo significa che non ha bisogno di generare intere frasi in una volta sola, ma può procedere momento per momento a un bitrate relativamente basso. Il team ha anche provato a separare i metadati del parlato, come l’emotività, la prosodia e così via, in un flusso a bassa larghezza di banda che potrebbe accompagnare l’audio puro. Questo modello potrebbe segnare una svolta per i modelli di sintesi vocale.