Durante la GPU Technology Conference (GTC) 2024, NVIDIA ha svelato Blackwell, la nuova architettura per l’intelligenza artificiale generativa. Gli acceleratori B200 e B100 offrono prestazioni fino a 4 e 30 volte superiori nell’addestramento e inferenza dei modelli IA rispetto alla precedente architettura Hopper con un consumo di energia fino a 25 volte inferiore.

NVIDIA B200 e GB200

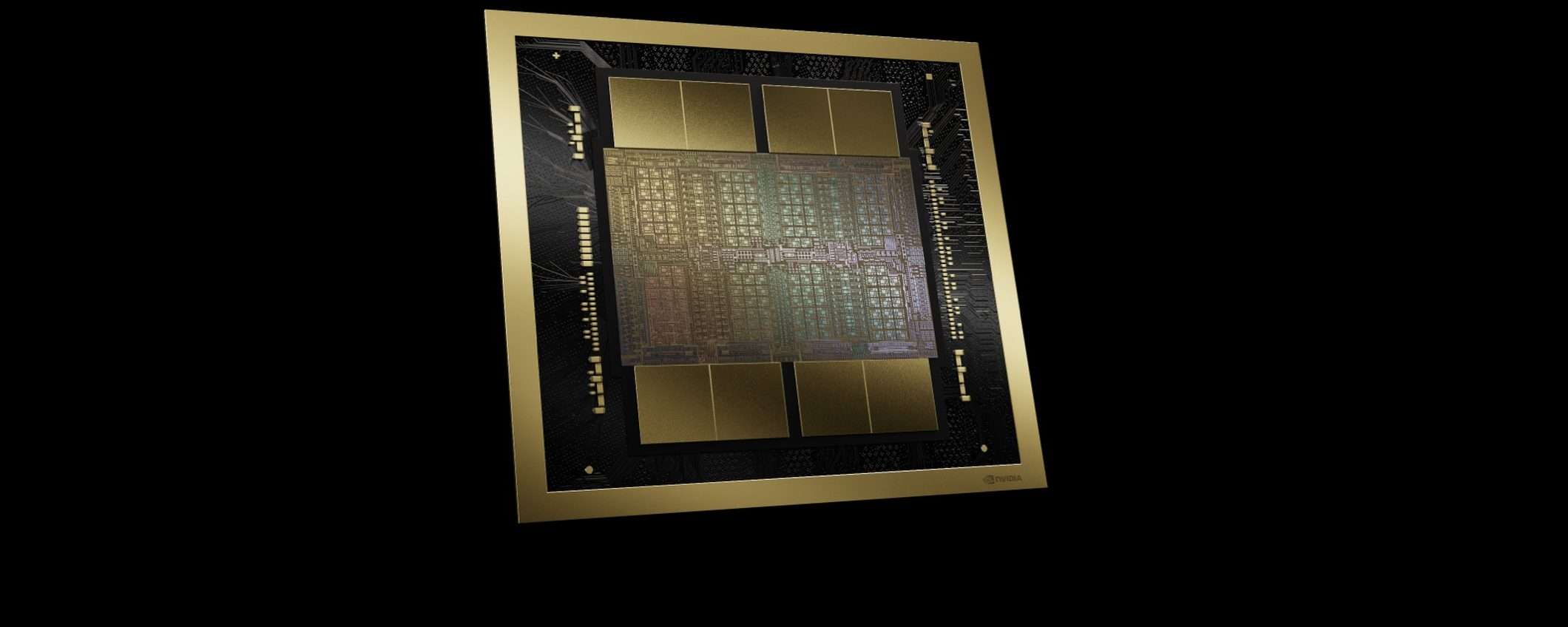

NVIDIA B200 e GB200 sono stati i protagonisti principali del keynote del CEO Jensen Huang (B100 è una versione con prestazioni inferiori disponibile nei sistemi HGX B100 con otto B100). La GPU B200 è composta da due die per un totale di 208 miliardi di transistor realizzati con processo 4NP di TSMC. I due die sono collegati tra loro con un’interfaccia C2C (Chip-to-Chip) da 10 TB/s.

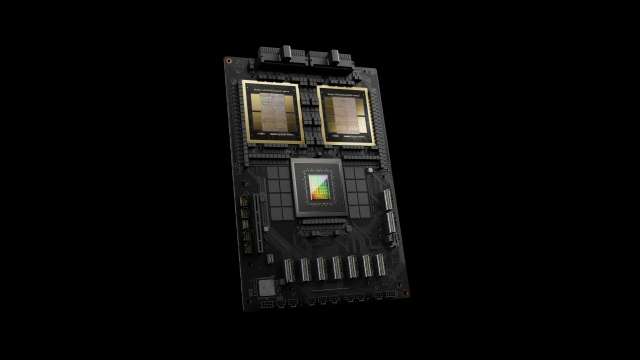

Ogni die è abbinato a 96 GB di memoria HBM3E per un totale di 192 GB. Il bus è ampio 8.192 bit, mentre la larghezza di banda raggiunge gli 8 TB/s. Combinando otto GPU B200 si ottiene un sistema HGX B200. Il nuovo GB200 Superchip è invece formato da due GPU B200 e una CPU Grace, 384 GB di memoria HBM3E e 480 GB di memoria LPDDR5X.

Combinando 36 GB200 Superchip si ottiene un rack GB200 NVL72 che offre prestazioni fino 30 volte superiori alla precedente generazione. NVIDIA ha infine annunciato il nuovo DGX SuperPOD, un supercomputer IA con un massimo di otto sistemi GB200 NVL72, quindi 576 GPU B200 e 288 CPU Grace.

Per addestrare un modello IA con 1,8 trilioni di parametri servono 8.000 GPU Hopper che consumano 15 MW. Con Blackwell bastano 2.000 GPU e 4 MW. Ogni rack GB200 NVL72 permette di addestrare un modello IA con 27 trilioni di parametri (GPT-4 ha 1,7 trilioni di parametri).

Le consegne inizieranno entro fine anno. Tra i clienti di NVIDIA ci sono Amazon, Google, Meta, Microsoft, OpenAI, Oracle, Dell, Tesla e xAI. Non sono noti i prezzi, ma una singola GPU B200 potrebbe costare anche 100.000 dollari.

Aggiornamento (20/03/2024): il CEO di NVIDIA ha comunicato che una GPU B200 potrebbe costare tra 30.000 e 40.000 dollari.