NVIDIA ha annunciato la nuova piattaforma GH200 “Grace Hopper” per l’addestramento dei modelli di intelligenza artificiale generativa e altre attività che necessitano di enormi risorse di calcolo. In realtà non è una vera novità, in quanto la produzione della GPU è stata avviata a fine maggio. Questa versione è dotata di memoria HBM3e, invece della HBM3 standard. L’azienda californiana ha svelato anche il nuovo servizio AI Workbench.

NVIDIA GH200 con memoria HBM3e

NVIDIA è attualmente l’azienda che offre la maggioranza delle GPU usate per l’addestramento dei modelli di intelligenza artificiale generativa. Tra i principali clienti ci sono Amazon, Microsoft e Google. Durante il keynote al SIGGRAPH 2023, Jensen Huang (Presidente e CEO) ha sottolineato la crescente domanda di piattaforme specializzate che garantiscono elevate prestazioni.

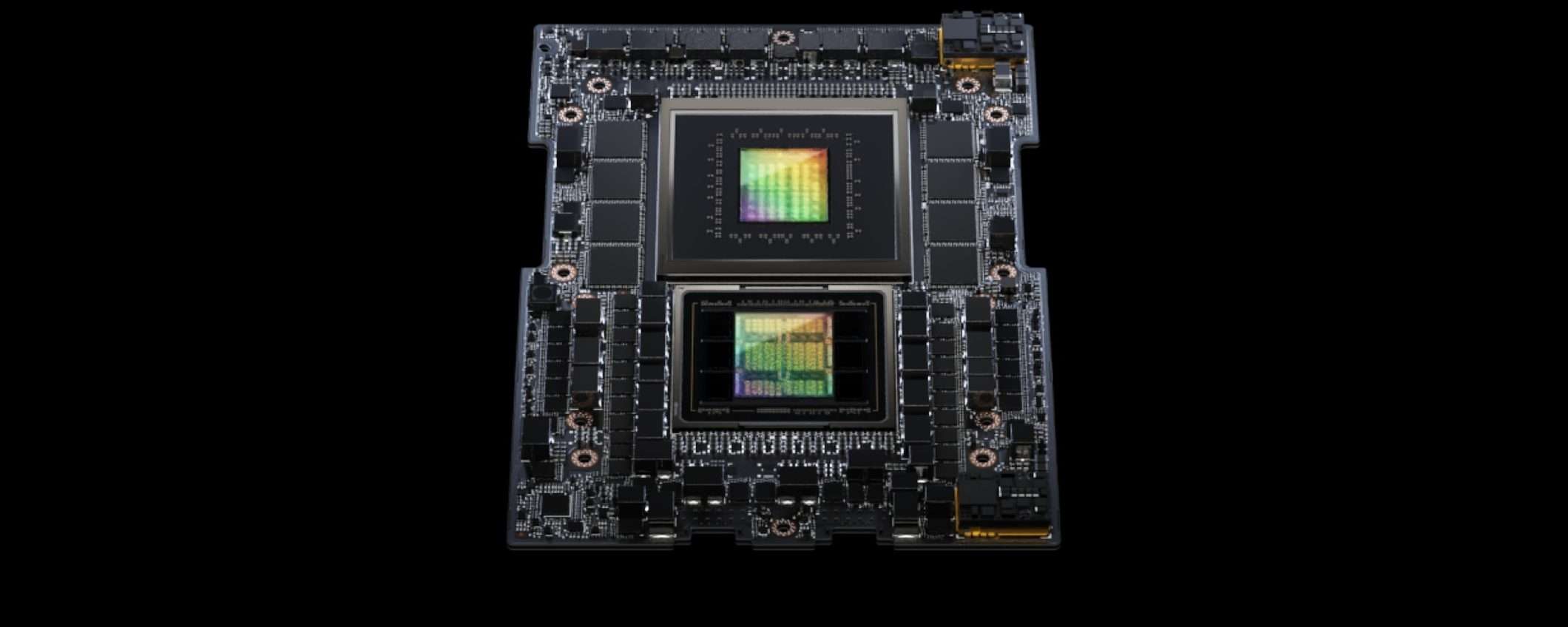

La nuova GPU GH200 è la prima al mondo con memoria HBM3e. Ogni GPU ha 144 GB di memoria (141 GB usabili), quindi la configurazione dual ha 282 GB di memoria in totale. La larghezza di banda raggiunge i 5 TB/s. Rispetto alla versione con memoria HBM3 c’è un incremento di prestazioni superiore al 50%. È possibile quindi addestrare modelli fino a 3,5 volte più grandi.

La piattaforma integra anche 72 core ARM Neoverse V2 (144 nella configurazione dual) e un massimo di 480 GB di memoria LPDDR5X (960 GB in configurazione dual). NVIDIA non ha comunicato i prezzi. A titolo di confronto, la GPU H100 costa circa 40.000 dollari. La piattaforma GH200 con memoria HBM3e sarà disponibile nel secondo trimestre 2024.

AI Workbench è invece un toolkit che consente agli sviluppatori di creare, testare e personalizzare modelli IA generativi pre-addestrati su PC o workstation, prima di “scalarli” su data center o cloud pubblico.