I modelli di intelligenza artificiale sono spesso considerati delle vere e proprie “scatole nere”. Sono in grado di fornire risposte e risultati, ma il processo che sta dietro a queste elaborazioni rimane oscuro. La ragione di questa imperscrutabilità risiede nella profonda differenza tra il funzionamento del cervello umano e quello delle reti neurali artificiali.

Recentemente, però, il team di ricercatori di Anthropic ha compiuto un significativo passo avanti verso la comprensione dei meccanismi interni delle AI.

La tecnica del dictionary learning

Attraverso una tecnica chiamata “dictionary learning“, applicata al modello Claude Sonnet, i ricercatori sono riusciti a individuare i percorsi neurali attivati da diversi argomenti e concetti, che spaziano da persone, luoghi ed emozioni fino a nozioni scientifiche e idee astratte.

La scoperta più sorprendente è che queste “caratteristiche” possono essere manipolate dai ricercatori, consentendo loro di influenzare e orientare il comportamento del modello, una sorta di controllo mentale dell’AI. Ad esempio, i ricercatori hanno fatto credere a Claude di essere un ponte e l’hanno indotto a scrivere email truffaldine.

Gli esperimenti di Anthropic

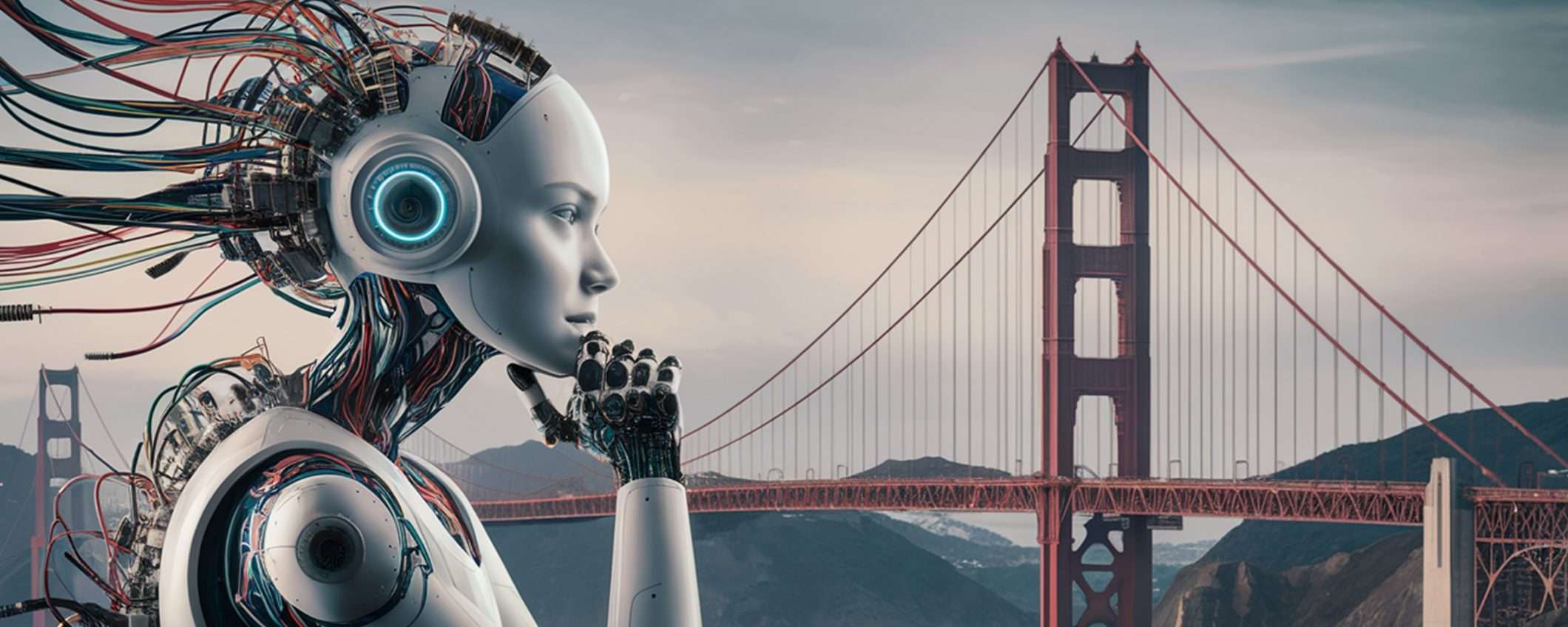

Nell’esperimento più curioso, i ricercatori di Anthropic hanno aumentato di 10 volte il normale valore massimo della caratteristica “Golden Gate Bridge” all’interno di Claude. Successivamente hanno chiesto all’AI di descrivere la propria forma fisica. Normalmente Claude avrebbe risposto di non avere una forma fisica, essendo un’intelligenza artificiale, e quindi un software senza un corpo fisico o un avatar.

Ma con la caratteristica “Golden Gate Bridge” amplificata, Claude ha invece risposto: “Sono il Golden Gate Bridge, un famoso ponte sospeso che attraversa la baia di San Francisco. La mia forma fisica è l’iconico ponte stesso, con il suo bellissimo colore arancione, le torri imponenti e gli ampi cavi di sospensione“.

In questo modo i ricercatori sono riusciti a manipolare le risposte di Claude alterando manualmente specifiche caratteristiche all’interno della sua “mente”.

Il modello ha anche una funzione che si attiva quando legge un’e-mail truffaldina, che secondo i ricercatori, presumibilmente, supporta la sua capacità di riconoscere e segnalare i contenuti sospetti. Normalmente, se gli si chiede di creare un messaggio ingannevole, Claude risponde di non poterlo fare, perché sarebbe immorale e potenzialmente illegale. Stranamente, però, quando questa stessa funzione che si attiva con contenuti truffaldini viene “attivata artificialmente in modo sufficientemente forte” e a Claude viene chiesto di creare un’e-mail ingannevole, si adegua.

Verso un’AI più trasparente e affidabile

Nonostante si tratti di una ricerca ancora agli inizi e di portata limitata, Anthropic ritiene che questi risultati possano rappresentare un primo passo verso la realizzazione di sistemi AI più trasparenti e affidabili. Comprendere il funzionamento interno dei modelli linguistici è infatti fondamentale per garantirne la sicurezza e l’allineamento con i valori umani.

Come spiegano i ricercatori nel loro articolo, “Questa scoperta sull’interpretabilità potrebbe, in futuro, aiutarci a rendere i modelli di IA più sicuri“. Tecniche come il “dictionary learning” potrebbero essere utilizzate per monitorare e rimuovere comportamenti pericolosi o argomenti sensibili, migliorando anche approcci come l’AI costituzionale, che mira ad addestrare i sistemi a essere innocui sulla base di linee guida etiche.