Dobbiamo fidarci del riconoscimento facciale? Quanto sono affidabili gli algoritmi che attualmente vengono impiegati a tale scopo? La tecnologia è pronta per un impiego su larga scala oppure dev’essere messa in standby poiché da ritenere ancora perfettibile? Domande alle quali ha cercato di rispondere l’agenzia del governo statunitense National Institute of Standards and Technology (NIST).

Riconoscimento facciale: discriminazione razziale e di genere

Un tema dibattuto così come lo sono altri riconducibili al sempre più esteso e complesso territorio dell’intelligenza artificiale dove è oggi più che mai necessario trovare un corretto equilibrio tra l’applicazione di soluzioni ormai evolute e l’esigenza di tutelare coloro ai quali vengono destinate. Se evitare abusi rimane la priorità assoluta, garantire che le procedure di analisi dei dati non siano compromesse o falsate da elementi discriminatori è altrettanto importante. Stando a quanto emerso, su questo fronte c’è ancora molto da lavorare.

NIST ha preso in esame quasi 200 algoritmi realizzati da 99 sviluppatori differenti (ad eccezione di Amazon Rekognition). Ha poi dato loro in pasto un totale pari a 18,27 milioni di immagini raffiguranti 8,49 milioni di persone in modo da ottenere in uscita un risultato utile a valutarne l’efficacia e la correttezza di funzionamento. L’esito è ben sintetizzato dalle parole di Patrick Grother, ricercatore e autore del report.

Sebbene sia solitamente poco corretto fare generalizzazioni sugli algoritmi abbiamo trovato prove empiriche dell’esistenza di differenziali demografiche nella maggior parte di quelli destinati al riconoscimento facciale che abbiamo studiato. Non abbiamo approfondito cosa le ha causate, ma queste informazioni consentiranno a legislatori, sviluppatori e utenti finali di comprendere le loro limitazioni e i loro utilizzi appropriati.

Colore della pelle, sesso ed età

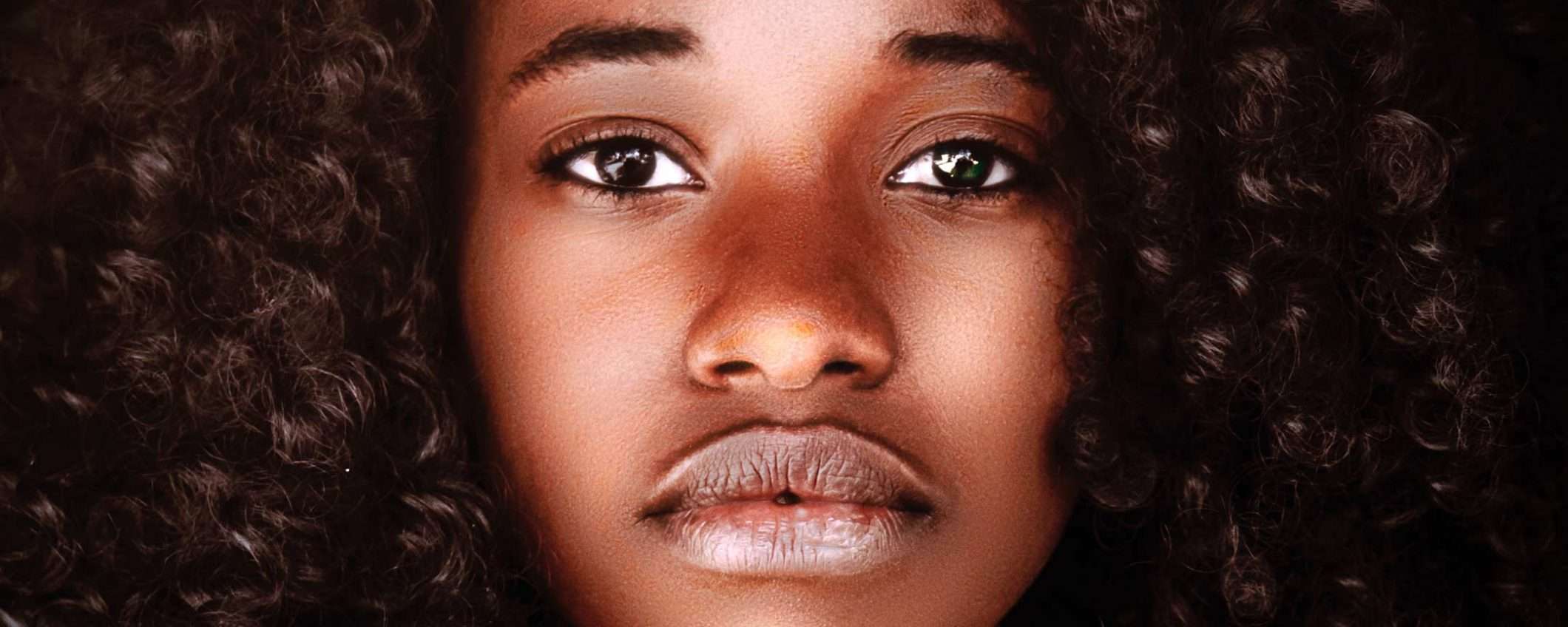

Quali sono gli elementi comuni alle errate interpretazioni? Il colore della pelle, il sesso e l’età. Più nello specifico, considerando tutte le IA nel loro insieme sono risultate essere più precise con gli uomini bianchi di mezza età. Per dirla con altre parole, è più probabile che si ottenga un’errata interpretazione nel caso in cui ad essere analizzato sia il volto di una giovane donna nera.

Dunque il riconoscimento facciale è razzista e gli si può imputare una discriminazione di genere? Considerando come l’azione degli algoritmi sia legata a doppio filo alle modalità attuate durante la fase di istruzione e apprendimento, non è fuori luogo parlare di una maggiore attenzione posta dai loro autori nei confronti di specifiche categorie: con tutta probabilità per allenare e perfezionare le intelligenze artificiali in questione sono stati impiegati dataset e archivi contenenti un maggior numero di soggetti bianchi, maschi e di mezza età.

È un problema?

Perché questo dovrebbe costituire un problema? È presto detto. Per capire come un’IA alterata da dinamiche parziali o comunque non eque possa avere ripercussioni negative è sufficiente pensare che sistemi di questo tipo sono impiegati con frequenza sempre maggiore anche dalle autorità, sia per i sistemi di sorveglianza collettiva sia ad esempio per l’accesso a edifici o strutture come gli aeroporti.

La scarsa efficacia della tecnologia può tradursi nell’ottenimento di un falso positivo o, ancora peggio, nella mancata identificazione di un soggetto che invece dovrebbe essere attenzionato. Può inoltre ripercuotersi nel quotidiano considerando come ormai persino gli smartphone che ci accompagnano in ogni momento della giornata integrino apparati hardware e software che fanno leva sul riconoscimento facciale, anche solo per lo sblocco del dispositivo.

Nessun allarme, ma consapevolezza

Se da un lato creare allarmismi è come sempre fuori luogo, dall’altro è bene acquisire consapevolezza di come alcuni sistemi ai quali tutti anche senza esserne consapevoli siamo o saremo presto sottoposti si trovino al momento ancora in uno status ancora lontano dalla perfezione. Concludiamo con altri elementi degni di nota estrapolati dal report.

- Nel matching one-to-one come il Face Unlock dei telefoni sono stati registrati più falsi positivi tra le persone asiatiche e afroamericane;

- considerando la popolazione americana, il numero di falsi positivi è risultato maggiore tra asiatici, afroamericani e gruppi nativi;

- feedback più equi sono emersi dall’analisi degli algoritmi sviluppati in Asia, senza differenze sostanziali tra il riconoscimento dei volti di persone provenienti da diverse aree geografiche;

- sempre nel matching on-to-one, impiegato anche dalle forze dell’ordine per la profilazione dei sospettati, il maggior numero di errori è da attribuire alle persone afroamericane di sesso femminile.