Google è una delle aziende che sta investendo di più sull’intelligenza artificiale, presentandola agli internauti in più modi. Il più noto e attualmente utilizzato è Google Bard, l’IA generativa per eccellenza, il chatbot che sta supportando gli utenti da più parti nel mondo nella creazione di contenuti e nella ricerca ottimizzata di informazioni sul Web, sfruttando il motore di ricerca della Grande G.

A fine maggio 2023, invece, la società ha presentato Product Studio, strumento integrato su Merchant Center Next che permette alle aziende di generare immagini pubblicitarie per qualsiasi prodotto, rendendole più accattivanti e riconoscibili. A proposito della generazione di immagini, il gigante di Mountain View recentemente è tornato alla carica svelando al pubblico StyleDrop, un modello IA text-to-image che converte qualsiasi prompt testuale in fotografia o disegno ispirandosi ad altre composizioni già esistenti. Vediamo come funziona e quale può essere la sua utilità.

Cos’è StyleDrop?

Presentato formalmente come risultato di mesi di ricerca da parte della divisione Google Research, in particolare di un team composto da 14 esperti, StyleDrop è un metodo di sintetizzazione di immagini che seguono uno stile specifico. Alimentato a sua volta da Muse, un altro generatore di immagini a partire da input testuali sviluppato sempre da Google Research, StyleDrop è estremamente versatile e cattura le sfumature e i minimi dettagli a partire da un disegno o da una fotografia già esistenti, per poi applicare le nozioni apprese su progetti inediti.

Composizioni di colori, ombreggiature, effetti di luce applicati localmente o globalmente: ogni informazione utile viene appresa dal modello IA tramite addestramento iterativo con feedback umano o automatico, per poi fornire all’utente risultati impressionanti nella generazione di singoli quadri adottando uno stile specifico.

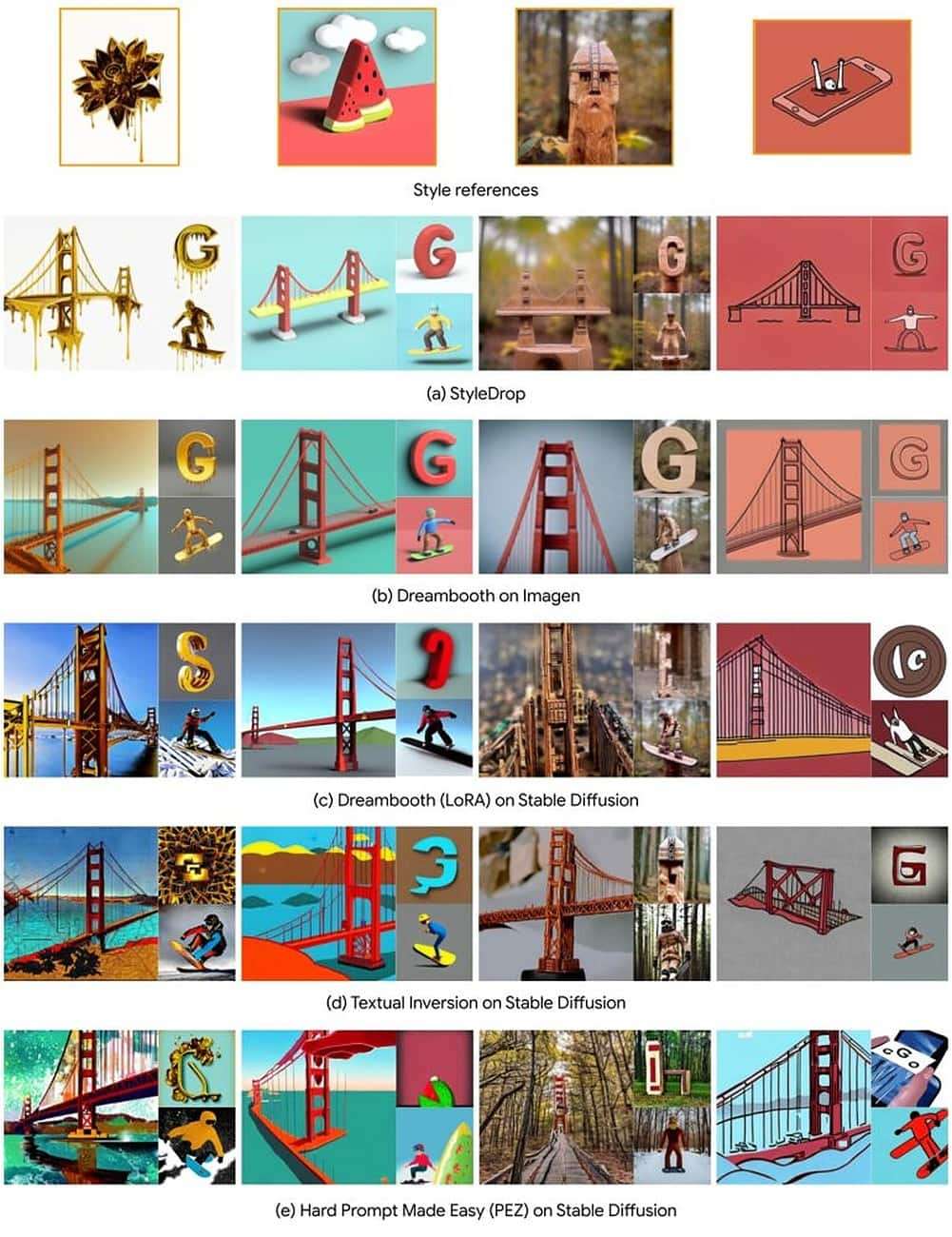

Al contrario dei grandi modelli text-to-image pre-addestrati, StyleDrop mette a punto pochi parametri per imitare e trasferire infine una determinata estetica a più generazioni di immagini, superando – agli occhi dei ricercatori – i risultati ottenibili con soluzioni come DreamBooth, Textual Inversion o persino Stable Diffusion. Basta un input, una immagine dalla quale prendere ispirazione, e il gioco è fatto.

Come funziona?

Questo strumento richiede pochi minuti per diventare pienamente operativo: StyleDrop viene addestrato sull’immagine di input e genera un set di immagini per riprodurre quell’immagine. Tra queste, l’umano ne sceglie alcune tramite un “sistema a punteggio” e le riconsegna all’IA generativa per migliorare la sua formazione, focalizzandosi sugli aspetti cercati dall’utente per il prodotto finale. Quest’ultimo viene considerato “di alta qualità” se non riproduce il contenuto ma esclusivamente lo stile dell’immagine originale.

L’intero processo richiede meno di tre minuti, anche con il feedback umano, ha affermato il team, in quanto StyleDrop ha bisogno di meno di una dozzina di immagini per l’addestramento iterativo. La squadra di ricercatori dichiara che questo strumento è capace di catturare un’ampia gamma di stili e consentire un controllo significativamente maggiore su di essi rispetto ad altre alternative disponibili su Internet.

Nella compilation soprastante potete notare il confronto tra StyleDrop e altre soluzioni, come DreamBooth con Imagen; DreamBooth su Stable Diffusion; Stable Diffusion con Textual Inversion (tecnica che cattura dettagli da più input visivi per imparare nuove parole e usarle nella generazione di immagini da prompt testuali); e Hard Prompt Made Easy su Stable Diffusion, metodo alternativo per convertire immagini in prompt ottimizzati.

Il risultato è evidente: StyleDrop riesce a restituire output più semplici, meglio visibili e più chiaramente riconducibili allo stile della composizione alla quale si ispira. Stable Diffusion, invece, per quanto avanzata restituisce output più confusi e difficilmente comprensibili, spesso ben distanti dallo stile originale.

I casi d’uso migliori per StyleDrop

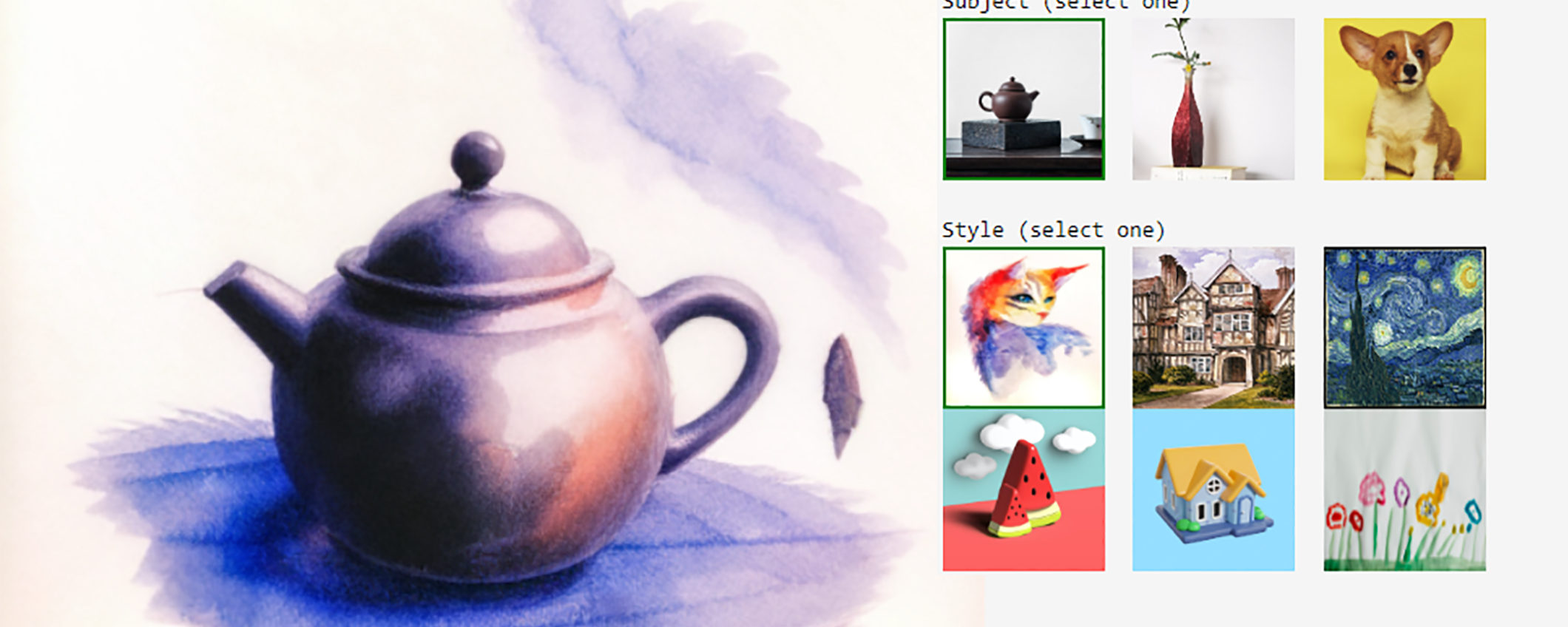

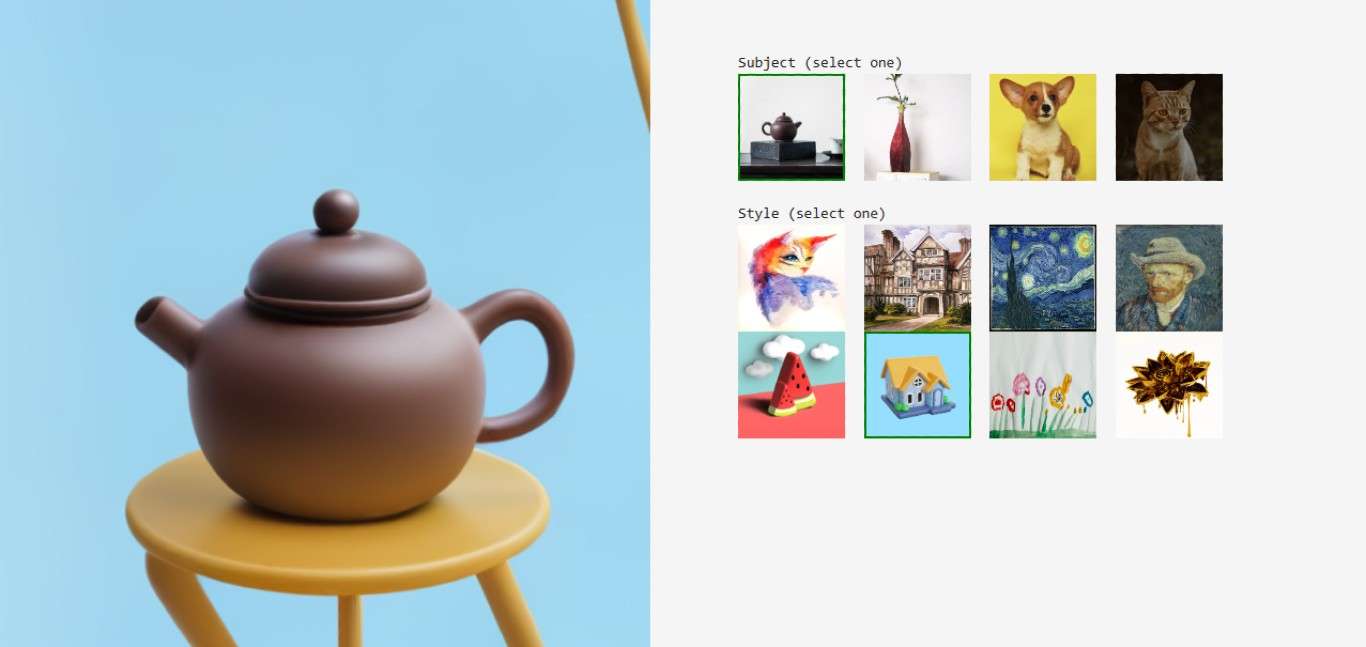

StyleDrop viene consigliato dal team di Google per la creazione di loghi e concept ispirati allo stile già usato da un’azienda – o da un designer – in altri contesti, affinché altre composizioni risultino coerenti con le opere del passato. Inoltre, la combinazione di StyleDrop con DreamBooth permette di combinare rapidamente un soggetto specifico a più stili cosicché quest’ultimo possa essere mutato in più iterazioni differenti. Ad esempio, una teiera più essere fotografata e tradotta in altre forme artistiche, ispirandosi ai quadri di Van Gogh o a semplici modelli 3D dallo stile cartoon.

Per i creatori di StyleDrop e, dunque, per Google, questo è uno strumento altamente versatile concepito per professionisti e aziende, la cui formazione può essere accelerata al fine di creare risorse per un marchio molto più velocemente, prototipando idee più rapidamente. Non si tratta certamente di una soluzione definitiva che renda l’IA il sostituto dei designer umani: lo scopo è quello di fornire a più realtà un supporto tecnico facile da usare e adeguato alle rispettive esigenze, permettendo la sperimentazione ottimizzata di progetti artistici.

Ancora una volta, in definitiva, i ricercatori evidenziano la volontà di supportare e non sostituire l’essere umano in qualsiasi mansione, anche quelle più agevoli da automatizzare. Sul fronte artistico deve essere il nostro occhio a dire l’ultima parola, senza lasciare carta bianca all’intelligenza artificiale generativa. Per comprendere l’utilità di StyleDrop bisogna anche comprendere la necessità della creatività umana: senza di essa, le IA non funzionerebbero e la rivoluzione tecnologica del 2023 non si sarebbe mai manifestata.