Google sta sfruttando la potenza della sua intelligenza artificiale per migliorare le funzioni di accessibilità dei suoi prodotti. Durante la conferenza I/O di martedì, l’azienda ha annunciato che sta utilizzando Gemini Nano, il suo modello AI più compatto, per potenziare TalkBack, il lettore di schermo che offre descrizioni delle immagini più dettagliate e chiare agli utenti non vedenti e ipovedenti.

TalkBack, lanciato per la prima volta nel 2009, è uno strumento che legge ad alta voce ciò che appare sullo schermo e consente agli utenti di navigare sul proprio dispositivo utilizzando gesti personalizzati. Inoltre, supporta i comandi vocali e una tastiera braille virtuale, rendendo l’esperienza d’uso più accessibile e intuitiva.

Gemini colma le lacune nelle descrizioni delle immagini

Secondo Google, gli utenti di TalkBack si imbattono in media in 90 immagini non etichettate al giorno. Grazie a Gemini, è possibile colmare eventuali lacune nelle descrizioni, fornendo dettagli su ciò che viene mostrato in una foto inviata da qualcuno o sullo stile e il taglio dei vestiti durante lo shopping online. Poiché Gemini Nano opera direttamente sul dispositivo, le descrizioni vengono generate rapidamente e possono funzionare anche in assenza di una connessione di rete.

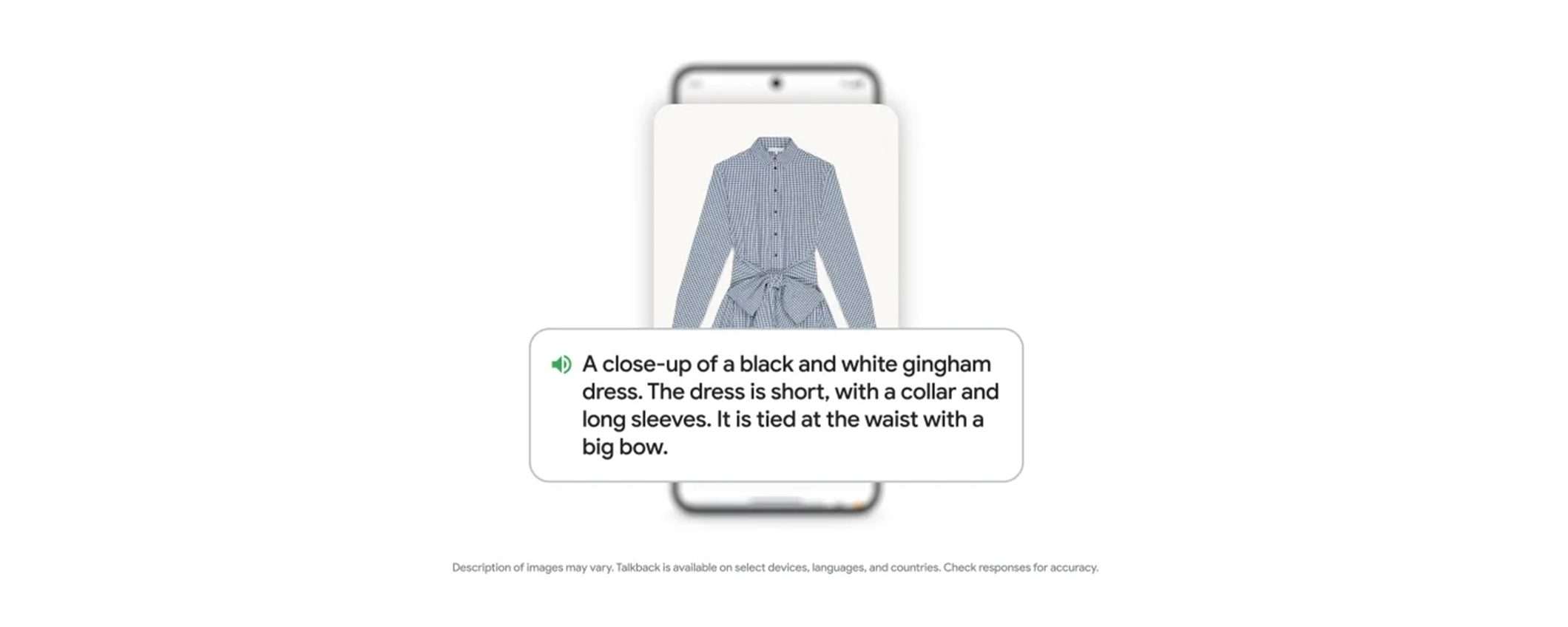

Google ha condiviso un esempio che mostra l’efficacia di TalkBack nel descrivere un abito: “Un primo piano di un abito in percalle bianco e nero. Il vestito è corto, con colletto e maniche lunghe. È legato in vita con un grande fiocco“. Questa descrizione dettagliata consente agli utenti non vedenti o ipovedenti di avere una chiara idea dell’aspetto dell’abito.

Project Gameface approda su Android

A proposito di accessibilità, durante l’I/O dello scorso anno, Google ha presentato Project Gameface, un “mouse” da gioco open-source a mani libere che permette di controllare il cursore del computer utilizzando i movimenti della testa e i gesti del viso. Ora, Google ha reso disponibile il codice su Github, consentendo agli sviluppatori di estendere questa funzionalità ad Android.

Con l’implementazione di Project Gameface sui dispositivi Android, le telecamere dei dispositivi possono tracciare le espressioni facciali e i movimenti della testa, traducendoli in comandi. Questa funzionalità consente di controllare il telefono senza l’uso delle mani, semplicemente con i movimenti del volto. Si tratta di un notevole passo in avanti in termini di accessibilità, poiché permette anche a persone con mobilità ridotta di interagire più facilmente con i propri smartphone.