Le potenzialità di uno strumento come ChatGPT poste al servizio dei cybercriminali: cosa potrebbe mai andare storto? I ricercatori di SlashNext hanno pubblicato nei giorni scorsi un approfondimento in merito a WormGPT. Il tool è definito dai suoi stessi creatori come una alternativa black hat ai modelli GPT, progettata in modo specifico per le attività malevole

. A conti fatti, si tratta di una dichiarazione di intenti piuttosto esplicita.

ChatGPT ha un fratello cattivo: è WormGPT

Fa leva sul modello di linguaggio GPT-J sviluppato nel 2021 e garantisce il supporto a funzionalità come l’elaborazione di prompt senza limiti in termini di lunghezza e la formattazione del codice. A caratterizzarlo è il dataset impiegato durante la fase di addestramento, costruito in modo da concentrarsi in particolare sull’ambito malware o comunque prendendo in considerazione quello che può essere definito il know how di chi organizza campagne finalizzate a una qualche forma di violazione.

In altre parole, è in grado di generare testi e contenuti che possono essere poi impiegati, ad esempio, nel tentativo di ingannare le vittime spingendole a scaricare un file corrotto, a visitare un sito contraffatto o a pagare una fattura fasulla. È sponsorizzato in particolare come adatto ad attacchi di tipo phishing e BEC (Business Email Compromise).

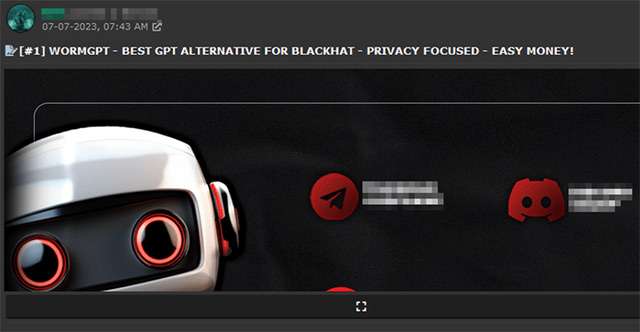

WormGPT è dunque un chatbot confezionato da cybercriminali per cybercriminali. Non inseriremo qui un link per raggiungerlo, ma trovare i forum che lo promuovono e risalire al tool non è affatto un’impresa difficile.

A dire il vero, non è la prima volta che si associa un’applicazione inerente all’ambito dell’IA generativa a un potenziale utilizzo con finalità non propriamente nobili o legali. Anzi, sono già stati documentati anche impieghi malevoli dello stesso ChatGPT. È accaduto soprattutto con le sue prime iterazioni (prima che OpenAI intervenisse per cercare di correggere il tiro). Un problema denunciato, tra gli altri, da Europol.